Distribution normale

En statistique , une distribution normale (également appelée distribution gaussienne , gauss ou distribution de Laplace-Gauss ) est un type de Distribution de probabilité continue pour une variable aléatoire à valeur réelle . La forme générale de sa fonction de densité de probabilité est

Fonction de densité de probabilité  La courbe rouge est la distribution normale standard La courbe rouge est la distribution normale standard |

|

Fonction de distribution cumulative  |

|

| Notation | N ( μ , σ 2 ) {displaystyle {mathcal {N}}(mu ,sigma ^{2})}  |

|---|---|

| Paramètres | μ ∈ R {displaystyle mu in mathbb {R}}  = moyenne ( emplacement ) = moyenne ( emplacement )σ 2 ∈ R > 0 {displaystyle sigma ^{2}in mathbb {R} _{>0}}  = variance ( échelle au carré ) = variance ( échelle au carré ) |

| Soutien | x ∈ R {displaystyle xin mathbb {R}}  |

1 σ 2 π e − 1 2 ( x − μ σ ) 2 {displaystyle {frac {1}{sigma {sqrt {2pi }}}}e^{-{frac {1}{2}}left({frac {x-mu }{ sigma }}right)^{2}}}  |

|

| CDF | 1 2 [ 1 + erf ( x − μ σ 2 ) ] {displaystyle {frac {1}{2}}left[1+operatorname {erf} left({frac {x-mu }{sigma {sqrt {2}}}}right) à droite]} ![{displaystyle {frac {1}{2}}left[1+operatorname {erf} left({frac {x-mu }{sigma {sqrt {2}}}}right)right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/187f33664b79492eedf4406c66d67f9fe5f524ea) |

| quantile | μ + σ 2 erf − 1 ( 2 p − 1 ) {displaystyle mu +sigma {sqrt {2}}operatorname {erf} ^{-1}(2p-1)}  |

| Moyenne | μ {displaystylemu}  |

| Médian | μ {displaystylemu}  |

| Mode | μ {displaystylemu}  |

| Variance | σ 2 {displaystyle sigma ^{2}}  |

| FURIEUX | σ 2 / π {displaystyle sigma {sqrt {2/pi }}}  |

| Asymétrie | 0 {displaystyle 0}  |

| Ex. aplatissement | 0 {displaystyle 0}  |

| Entropie | 1 2 log ( 2 π σ 2 ) + 1 2 {displaystyle {frac {1}{2}}log(2pi sigma ^{2})+{frac {1}{2}}}  |

| FMG | exp ( μ t + σ 2 t 2 / 2 ) {displaystyle exp(mu t+sigma ^{2}t^{2}/2)}  |

| FC | exp ( i μ t − σ 2 t 2 / 2 ) {displaystyle exp(imu t-sigma ^{2}t^{2}/2)}  |

| Informations sur les pêcheurs |

I ( μ , σ ) = ( 1 / σ 2 0 0 2 / σ 2 ) {displaystyle {mathcal {I}}(mu ,sigma )={begin{pmatrix}1/sigma ^{2}&0\0&2/sigma ^{2}end{pmatrix}}} I ( μ , σ 2 ) = ( 1 / σ 2 0 0 1 / ( 2 σ 4 ) ) {displaystyle {mathcal {I}}(mu ,sigma ^{2})={begin{pmatrix}1/sigma ^{2}&0\0&1/(2sigma ^{4}) end{pmatrice}}} |

| Divergence de Kullback-Leibler | 1 2 { ( σ 0 σ 1 ) 2 + ( μ 1 − μ 0 ) 2 σ 1 2 − 1 + ln σ 1 σ 0 } {displaystyle {1 over 2}left{left({frac {sigma _{0}}{sigma _{1}}}right)^{2}+{frac {( mu _{1}-mu _{0})^{2}}{sigma _{1}^{2}}}-1+ln {sigma _{1} over sigma _{0 }}à droite}}  |

f ( x ) = 1 σ 2 π e − 1 2 ( x − μ σ ) 2 {displaystyle f(x)={frac {1}{sigma {sqrt {2pi }}}}e^{-{frac {1}{2}}left({frac {x -mu }{sigma }}right)^{2}}}

Le paramètre μ {displaystylemu}

Les distributions normales sont importantes en statistique et sont souvent utilisées dans les sciences naturelles et sociales pour représenter des variables aléatoires à valeurs réelles dont les distributions ne sont pas connues. [2] [3] Leur importance est due en partie au théorème central limite . Il stipule que, sous certaines conditions, la moyenne de nombreux échantillons (observations) d’une variable aléatoire avec une moyenne et une variance finies est elle-même une variable aléatoire – dont la distribution converge vers une distribution normale à mesure que le nombre d’échantillons augmente. Par conséquent, les grandeurs physiques censées être la somme de nombreux processus indépendants, tels que les erreurs de mesure, ont souvent des distributions presque normales. [4]

De plus, les distributions gaussiennes ont des propriétés uniques qui sont précieuses dans les études analytiques. Par exemple, toute combinaison linéaire d’une collection fixe d’écarts normaux est un écart normal. De nombreux résultats et méthodes, tels que la propagation de l’incertitude et l’ajustement des paramètres des moindres carrés , peuvent être dérivés analytiquement sous une forme explicite lorsque les variables pertinentes sont normalement distribuées.

Une distribution normale est parfois appelée officieusement une courbe en cloche . [5] Cependant , de nombreuses autres distributions sont en forme de cloche (telles que les distributions de Cauchy , de Student et logistiques ).

La distribution de probabilité univariée est généralisée pour les vecteurs dans la distribution normale multivariée et pour les matrices dans la distribution normale matricielle .

Définitions

Distribution normale standard

Le cas le plus simple d’une distribution normale est connu sous le nom de distribution normale standard ou distribution normale unitaire . Il s’agit d’un cas particulier lorsque μ = 0 {displaystylemu =0}

et σ = 1 {displaystylesigma =1}

, et il est décrit par cette fonction de densité de probabilité (ou densité) :

φ ( z ) = e − z 2 2 2 π {displaystyle varphi (z)={frac {e^{-{frac {z^{2}}{2}}}}{sqrt {2pi }}}}

La variable z {displaystyle z}

a une moyenne de 0 et une variance et un écart-type de 1. La densité φ ( z ) {displaystyle varphi (z)}

a son apogée 1 / 2 π {displaystyle 1/{sqrt {2pi }}}

à z = 0 {style d’affichage z=0}

et des points d’inflexion à z = + 1 {displaystyle z=+1}

et z = − 1 {displaystyle z=-1}

.

Bien que la densité ci-dessus soit plus communément connue sous le nom de normale standard, quelques auteurs ont utilisé ce terme pour décrire d’autres versions de la distribution normale. Carl Friedrich Gauss , par exemple, a un jour défini la normale standard comme

φ ( z ) = e − z 2 π {displaystyle varphi (z)={frac {e^{-z^{2}}}{sqrt {pi }}}}

qui a une variance de 1/2, et Stephen Stigler [6] a défini une fois la normale standard comme

φ ( z ) = e − π z 2 {displaystyle varphi (z)=e^{-pi z^{2}}}

qui a une forme fonctionnelle simple et une variance de σ 2 = 1 / ( 2 π ) {displaystyle sigma ^{2}=1/(2pi)}

:

Distribution normale générale

Chaque distribution normale est une version de la distribution normale standard, dont le domaine a été étiré d’un facteur σ {displaystylesigma}

f ( x ∣ μ , σ 2 ) = 1 σ φ ( x − μ σ ) {displaystyle f(xmid mu ,sigma ^{2})={frac {1}{sigma }}varphi left({frac {x-mu }{sigma }} à droite)}

La densité de probabilité doit être mise à l’échelle par 1 / σ {displaystyle 1/sigma}

de sorte que l’intégrale vaut toujours 1.

Si Z {displaystyle Z}

est un écart normal standard , alors X = σ Z + μ {displaystyle X=sigma Z+mu }

aura une distribution normale avec une valeur attendue μ {displaystylemu}

et écart-type σ {displaystylesigma}

. Cela revient à dire que la distribution normale “standard” Z {displaystyle Z}

peut être mis à l’échelle/étiré d’un facteur de σ {displaystylesigma}

et déplacé de μ {displaystylemu}

pour produire une distribution normale différente, appelée X {displaystyle X}

. A l’inverse, si X {displaystyle X}

est un écart normal avec des paramètres μ {displaystylemu}

et σ 2 {displaystyle sigma ^{2}}

, ensuite ceci X {displaystyle X}

la distribution peut être redimensionnée et décalée via la formule Z = ( X − μ ) / σ {displaystyle Z=(X-mu )/sigma}

pour le convertir en distribution normale “standard”. Cette variable est aussi appelée la forme standardisée de X {displaystyle X}

.

Notation

La densité de probabilité de la distribution gaussienne standard (distribution normale standard, avec une moyenne nulle et une variance unitaire) est souvent désignée par la lettre grecque φ {displaystylephi}

( phi ). [7] La forme alternative de la lettre grecque phi, φ {displaystylevarphi }

, est également utilisé assez souvent.

La distribution normale est souvent appelée N ( μ , σ 2 ) {displaystyle N(mu ,sigma ^{2})}

ou alors N ( μ , σ 2 ) {displaystyle {mathcal {N}}(mu ,sigma ^{2})}

. [8] Ainsi lorsqu’une variable aléatoire X {displaystyle X}

est normalement distribué avec une moyenne μ {displaystylemu}

et écart-type σ {displaystylesigma}

, on peut écrire

X ∼ N ( μ , σ 2 ) . {displaystyle Xsim {mathcal {N}}(mu ,sigma ^{2}).}

Paramétrages alternatifs

Certains auteurs préconisent d’utiliser la précision τ {displaystyletau}

comme paramètre définissant la largeur de la distribution, au lieu de l’écart σ {displaystylesigma}

ou la variance σ 2 {displaystyle sigma ^{2}}

. La précision est normalement définie comme l’inverse de la variance, 1 / σ 2 {displaystyle 1/sigma ^{2}}

. [9] La formule de la distribution devient alors

f ( x ) = τ 2 π e − τ ( x − μ ) 2 / 2 . {displaystyle f(x)={sqrt {frac {tau }{2pi }}}e^{-tau (x-mu )^{2}/2}.}

Ce choix est revendiqué comme ayant des avantages dans les calculs numériques lorsque σ {displaystylesigma}

est très proche de zéro et simplifie les formules dans certains contextes, comme dans l’ inférence bayésienne de variables avec une distribution normale multivariée .

Alternativement, l’inverse de l’écart type τ ′ = 1 / σ {displaystyle tau ^{prime}=1/sigma}

peut être définie comme la précision , auquel cas l’expression de la distribution normale devient

f ( x ) = τ ′ 2 π e − ( τ ′ ) 2 ( x − μ ) 2 / 2 . {displaystyle f(x)={frac {tau ^{prime }}{sqrt {2pi }}}e^{-(tau ^{prime })^{2}(x- mu )^{2}/2}.}

Selon Stigler, cette formulation est avantageuse en raison d’une formule beaucoup plus simple et plus facile à retenir, et de formules approchées simples pour les quantiles de la distribution.

Les distributions normales forment une famille exponentielle avec des paramètres naturels θ 1 = μ σ 2 {displaystyle textstyle theta _{1}={frac {mu }{sigma ^{2}}}}

et θ 2 = − 1 2 σ 2 {displaystyle textstyle theta _{2}={frac {-1}{2sigma ^{2}}}}

, et statistiques naturelles x et x 2 . Les paramètres d’espérance double pour la distribution normale sont η 1 = μ et η 2 = μ 2 + σ 2 .

Fonctions de distribution cumulées

La fonction de distribution cumulative (CDF) de la distribution normale standard, généralement désignée par la lettre grecque majuscule Φ {displaystyle Phi}

( phi ), est l’intégrale

Φ ( x ) = 1 2 π ∫ − ∞ x e − t 2 / 2 d t {displaystyle Phi (x)={frac {1}{sqrt {2pi }}}int _{-infty}^{x}e^{-t^{2}/2} ,dt}

La fonction d’erreur associée erf ( x ) {displaystyle operatorname {erf} (x)}

donne la probabilité d’une variable aléatoire, avec une distribution normale de moyenne 0 et de variance 1/2 tombant dans la plage [ − x , x ] {displaystyle [-x,x]}

![[-x,x]](https://wikimedia.org/api/rest_v1/media/math/render/svg/e23c41ff0bd6f01a0e27054c2b85819fcd08b762)

. C’est:

erf ( x ) = 2 π ∫ 0 x e − t 2 d t {displaystyle operatorname {erf} (x)={frac {2}{sqrt {pi }}}int _{0}^{x}e^{-t^{2}},dt }

Ces intégrales ne peuvent pas être exprimées en termes de fonctions élémentaires et sont souvent qualifiées de fonctions spéciales . Cependant, de nombreuses approximations numériques sont connues ; voir ci- dessous pour plus.

Les deux fonctions sont étroitement liées, à savoir

Φ ( x ) = 1 2 [ 1 + erf ( x 2 ) ] {displaystyle Phi (x)={frac {1}{2}}left[1+operatorname {erf} left({frac {x}{sqrt {2}}}right) à droite]} ![{displaystyle Phi (x)={frac {1}{2}}left[1+operatorname {erf} left({frac {x}{sqrt {2}}}right)right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c7831a9a5f630df7170fa805c186f4c53219ca36)

Pour une distribution normale générique avec densité f {displaystyle f}

, moyenne μ {displaystylemu}

et déviation σ {displaystylesigma}

, la fonction de distribution cumulative est

F ( x ) = Φ ( x − μ σ ) = 1 2 [ 1 + erf ( x − μ σ 2 ) ] {displaystyle F(x)=Phi left({frac {x-mu }{sigma }}right)={frac {1}{2}}left[1+operatorname {erf } left({frac {x-mu }{sigma {sqrt {2}}}}right)right]} ![{displaystyle F(x)=Phi left({frac {x-mu }{sigma }}right)={frac {1}{2}}left[1+operatorname {erf} left({frac {x-mu }{sigma {sqrt {2}}}}right)right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/75deccfbc473d782dacb783f1524abb09b8135c0)

Le complément du CDF normal standard, Q ( x ) = 1 − Φ ( x ) {displaystyle Q(x)=1-Phi (x)}

, est souvent appelée la fonction Q , en particulier dans les textes d’ingénierie. [10] [11] Il donne la probabilité que la valeur d’une variable aléatoire normale standard X {displaystyle X}

dépassera x {style d’affichage x}

: P ( X > x ) {displaystyle P(X>x)}

. D’autres définitions du Q {displaystyle Q}

-fonction, qui sont toutes de simples transformations de Φ {displaystyle Phi}

, sont également utilisés occasionnellement. [12]

Le graphique du CDF normal standard Φ {displaystyle Phi}

a une symétrie de rotation double autour du point (0,1/2); C’est, Φ ( − x ) = 1 − Φ ( x ) {displaystyle Phi (-x)=1-Phi (x)}

. Sa primitive (intégrale indéfinie) peut être exprimée comme suit :

∫ Φ ( x ) d x = x Φ ( x ) + φ ( x ) + C . {displaystyle int Phi (x),dx=xPhi (x)+varphi (x)+C.}

La CDF de la distribution normale standard peut être étendue par intégration par parties dans une série :

Φ ( x ) = 1 2 + 1 2 π ⋅ e − x 2 / 2 [ x + x 3 3 + x 5 3 ⋅ 5 + ⋯ + x 2 n + 1 ( 2 n + 1 ) ! ! + ⋯ ] {displaystyle Phi (x)={frac {1}{2}}+{frac {1}{sqrt {2pi }}}cdot e^{-x^{2}/2} left[x+{frac {x^{3}}{3}}+{frac {x^{5}}{3cdot 5}}+cdots +{frac {x^{2n+1 }}{(2n+1)!!}}+cdots right]} ![{displaystyle Phi (x)={frac {1}{2}}+{frac {1}{sqrt {2pi }}}cdot e^{-x^{2}/2}left[x+{frac {x^{3}}{3}}+{frac {x^{5}}{3cdot 5}}+cdots +{frac {x^{2n+1}}{(2n+1)!!}}+cdots right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/54d12af9a3b12a7f859e4e7be105d172b53bcfb8)

où ! ! {displaystyle !!}

désigne la factorielle double .

Une expansion asymptotique de la CDF pour un grand x peut également être dérivée en utilisant l’intégration par parties. Pour plus d’informations, voir Error function#Asymptotic expansion . [13]

Une approximation rapide du CDF de la distribution normale standard peut être trouvée en utilisant une approximation en série de Taylor :

Φ ( x ) ≈ 1 2 + 1 2 π ∑ k = 0 n ( − 1 ) k x ( 2 k + 1 ) 2 k k ! ( 2 k + 1 ) {displaystyle Phi (x)approx {frac {1}{2}}+{frac {1}{sqrt {2pi }}}sum _{k=0}^{n}{ frac {left(-1right)^{k}x^{left(2k+1right)}}{2^{k}k!left(2k+1right)}}}

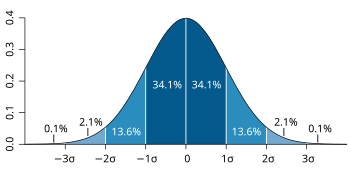

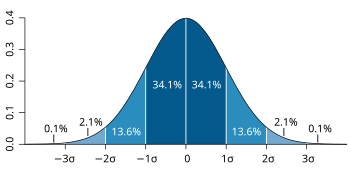

Écart-type et couverture

Pour la distribution normale, les valeurs à moins d’un écart type de la moyenne représentent 68,27 % de l’ensemble ; tandis que deux écarts types par rapport à la moyenne représentent 95,45 % ; et trois écarts-types représentent 99,73 %.

Pour la distribution normale, les valeurs à moins d’un écart type de la moyenne représentent 68,27 % de l’ensemble ; tandis que deux écarts types par rapport à la moyenne représentent 95,45 % ; et trois écarts-types représentent 99,73 %.

Environ 68 % des valeurs tirées d’une distribution normale se situent à moins d’un écart type σ de la moyenne ; environ 95 % des valeurs se situent à moins de deux écarts-types ; et environ 99,7 % se situent à moins de trois écarts-types. [5] Ce fait est connu sous le nom de règle 68-95-99.7 (empirique) ou règle des 3 sigma .

Plus précisément, la probabilité qu’un écart normal soit compris entre μ − n σ {displaystyle mu -nsigma }

et μ + n σ {displaystyle mu +nsigma }

est donné par

F ( μ + n σ ) − F ( μ − n σ ) = Φ ( n ) − Φ ( − n ) = erf ( n 2 ) . {displaystyle F(mu +nsigma )-F(mu -nsigma )=Phi (n)-Phi (-n)=operatorname {erf} left({frac {n} {sqrt {2}}}right).}

A 12 chiffres significatifs, les valeurs de n = 1 , 2 , … , 6 {displaystyle n=1,2,ldots,6}

sont : [14]

n {displaystyle n}  |

p = F ( μ + n σ ) − F ( μ − n σ ) {displaystyle p=F(mu +nsigma )-F(mu -nsigma )}  |

i.e. 1 − p {displaystyle {text{c’est-à-dire}}1-p}  |

or 1 in p {displaystyle {text{ou }}1{text{ dans }}p}  |

OEIS | ||

|---|---|---|---|---|---|---|

| 1 | 0,682 689 492 137 | 0,317 310 507 863 |

|

OEIS : A178647 | ||

| 2 | 0,954 499 736 104 | 0,045 500 263 896 |

|

OEIS : A110894 | ||

| 3 | 0,997 300 203 937 | 0,002 699 796 063 |

|

OEIS : A270712 | ||

| 4 | 0,999 936 657 516 | 0,000 063 342 484 |

|

|||

| 5 | 0,999 999 426 697 | 0,000 000 573 303 |

|

|||

| 6 | 0,999 999 998 027 | 0,000 000 001 973 |

|

Pour les grands n {displaystyle n}

, on peut utiliser l’approximation 1 − p ≈ e − n 2 / 2 n π / 2 {displaystyle 1-papprox {frac {e^{-n^{2}/2}}{n{sqrt {pi /2}}}}}

.

Fonction quantile

La fonction quantile d’une distribution est l’inverse de la fonction de distribution cumulative. La fonction quantile de la distribution normale standard est appelée fonction probit et peut être exprimée en fonction de la fonction d’ erreur inverse :

Φ − 1 ( p ) = 2 erf − 1 ( 2 p − 1 ) , p ∈ ( 0 , 1 ) . {displaystyle Phi ^{-1}(p)={sqrt {2}}operatorname {erf} ^{-1}(2p-1),quad pin (0,1).}

Pour une variable aléatoire normale de moyenne μ {displaystylemu}

et variance σ 2 {displaystyle sigma ^{2}}

, la fonction quantile est

F − 1 ( p ) = μ + σ Φ − 1 ( p ) = μ + σ 2 erf − 1 ( 2 p − 1 ) , p ∈ ( 0 , 1 ) . {displaystyle F^{-1}(p)=mu +sigma Phi ^{-1}(p)=mu +sigma {sqrt {2}}operatorname {erf} ^{-1 }(2p-1),quad pin (0,1).}

Le quantile Φ − 1 ( p ) {displaystyle Phi ^{-1}(p)}

de la distribution normale standard est communément notée z p {displaystyle z_{p}}

. Ces valeurs sont utilisées dans les tests d’hypothèses , la construction d’ intervalles de confiance et les diagrammes Q–Q . Une variable aléatoire normale X {displaystyle X}

dépassera μ + z p σ {displaystyle mu +z_{p}sigma }

avec probabilité 1 − p {displaystyle 1-p}

, et se trouvera en dehors de l’intervalle μ ± z p σ {displaystyle mu pm z_{p}sigma }

avec probabilité 2 ( 1 − p ) {displaystyle 2(1-p)}

. En particulier, le quantile z 0.975 {displaystyle z_{0.975}}

est de 1,96 ; donc une variable aléatoire normale se trouvera en dehors de l’intervalle μ ± 1.96 σ {displaystyle mu pm 1.96sigma }

dans seulement 5% des cas.

Le tableau suivant donne le quantile z p {displaystyle z_{p}}

tel que X {displaystyle X}

se situera dans la gamme μ ± z p σ {displaystyle mu pm z_{p}sigma }

avec une probabilité spécifiée p {displaystyle p}

. Ces valeurs sont utiles pour déterminer l’ intervalle de tolérance pour les moyennes d’échantillons et d’autres estimateurs statistiques avec des distributions normales (ou asymptotiquement normales). [15] [16] Notez que le tableau suivant montre 2 erf − 1 ( p ) = Φ − 1 ( p + 1 2 ) {displaystyle {sqrt {2}}operatorname {erf} ^{-1}(p)=Phi ^{-1}left({frac {p+1}{2}}right)}

, ne pas Φ − 1 ( p ) {displaystyle Phi ^{-1}(p)}

tel que défini ci-dessus.

p {displaystyle p}  |

z p {displaystyle z_{p}}  |

p {displaystyle p}  |

z p {displaystyle z_{p}}  |

|---|---|---|---|

| 0,80 | 1.281 551 565 545 | 0,999 | 3.290 526 731 492 |

| 0,90 | 1.644 853 626 951 | 0,9999 | 3.890 591 886 413 |

| 0,95 | 1.959 963 984 540 | 0,99999 | 4.417 173 413 469 |

| 0,98 | 2.326 347 874 041 | 0,999999 | 4.891 638 475 699 |

| 0,99 | 2.575 829 303 549 | 0,9999999 | 5.326 723 886 384 |

| 0,995 | 2.807 033 768 344 | 0,99999999 | 5.730 728 868 236 |

| 0,998 | 3.090 232 306 168 | 0,999999999 | 6.109 410 204 869 |

Pour les petits p {displaystyle p}

, la fonction quantile a le développement asymptotique utile Φ − 1 ( p ) = − ln 1 p 2 − ln ln 1 p 2 − ln ( 2 π ) + o ( 1 ) . {displaystyle Phi ^{-1}(p)=-{sqrt {ln {frac {1}{p^{2}}}-ln ln {frac {1}{p^{ 2}}}-ln(2pi )}}+{mathcal {o}}(1).}

Propriétés

La distribution normale est la seule distribution dont les cumulants au-delà des deux premiers (c’est-à-dire autres que la moyenne et la variance ) sont nuls. C’est aussi la distribution continue avec l’ entropie maximale pour une moyenne et une variance spécifiées. [17] [18] Geary a montré, en supposant que la moyenne et la variance sont finies, que la distribution normale est la seule distribution où la moyenne et la variance calculées à partir d’un ensemble de tirages indépendants sont indépendantes l’une de l’autre. [19] [20]

La distribution normale est une sous-classe des distributions elliptiques . La distribution normale est symétrique par rapport à sa moyenne et est non nulle sur toute la ligne réelle. En tant que tel, il peut ne pas être un modèle approprié pour des variables intrinsèquement positives ou fortement biaisées, telles que le poids d’une personne ou le prix d’une action . Ces variables peuvent être mieux décrites par d’autres distributions, telles que la distribution log-normale ou la distribution de Pareto .

La valeur de la distribution normale est pratiquement nulle lorsque la valeur x {style d’affichage x}

se situe à plus de quelques écarts-types de la moyenne (par exemple, un écart de trois écarts-types couvre tout sauf 0,27 % de la distribution totale). Par conséquent, ce n’est peut-être pas un modèle approprié lorsque l’on s’attend à une fraction significative de valeurs aberrantes – des valeurs qui se situent à de nombreux écarts-types de la moyenne – et les moindres carrés et autres méthodes d’ inférence statistique qui sont optimales pour les variables normalement distribuées deviennent souvent très peu fiables lorsqu’elles sont appliquées . à de telles données. Dans ces cas, une distribution à queue plus lourde doit être supposée et les méthodes d’ inférence statistique robustes appropriées doivent être appliquées.

La distribution gaussienne appartient à la famille des distributions stables qui sont les attracteurs de sommes de distributions indépendantes et identiquement distribuées , que la moyenne ou la variance soit finie ou non. À l’exception de la gaussienne qui est un cas limite, toutes les distributions stables ont des queues lourdes et une variance infinie. C’est l’une des rares distributions qui soient stables et qui aient des fonctions de densité de probabilité exprimables analytiquement, les autres étant la distribution de Cauchy et la distribution de Lévy .

Symétries et dérivées

La distribution normale avec densité f ( x ) {displaystyle f(x)}

(moyenne μ {displaystylemu}

et écart-type σ > 0 {displaystylesigma >0}

) a les propriétés suivantes :

- Il est symétrique autour du point x = μ , {displaystyle x=mu ,}

qui est à la fois le mode , la médiane et la moyenne de la distribution. [21]

- Elle est unimodale : sa dérivée première est positive pour x < μ , {displaystyle x<mu ,}

négatif pour x > μ , {displaystyle x>mu ,}

et zéro seulement à x = μ . {displaystyle x=mu .}

- La zone délimitée par la courbe et la x {style d’affichage x}

-axe est l’unité (c’est-à-dire égal à un).

- Sa dérivée première est f ′ ( x ) = − x − μ σ 2 f ( x ) . {displaystyle f^{prime}(x)=-{frac {x-mu }{sigma ^{2}}}f(x).}

- Sa densité a deux points d’inflexion (où la dérivée seconde de f {displaystyle f}

est nul et change de signe), situé à un écart type de la moyenne, à savoir à x = μ − σ {displaystyle x=mu -sigma }

et x = μ + σ . {displaystyle x=mu +sigma .}

[21]

- Sa densité est log-concave . [21]

- Sa densité est infiniment dérivable , voire superlisse d’ordre 2. [22]

De plus, la densité φ {displaystylevarphi }

de la distribution normale standard (c’est-à-dire μ = 0 {displaystylemu =0}

et σ = 1 {displaystylesigma =1}

) possède également les propriétés suivantes :

- Sa dérivée première est φ ′ ( x ) = − x φ ( x ) . {displaystyle varphi ^{prime}(x)=-xvarphi (x).}

- Sa dérivée seconde est φ ′ ′ ( x ) = ( x 2 − 1 ) φ ( x ) {displaystyle varphi ^{prime prime}(x)=(x^{2}-1)varphi (x)}

- Plus généralement, sa n ième dérivée est φ ( n ) ( x ) = ( − 1 ) n He n ( x ) φ ( x ) , {displaystyle varphi ^{(n)}(x)=(-1)^{n}operatorname {He} _{n}(x)varphi (x),}

où He n ( x ) {displaystyle operatorname {Il} _{n}(x)}

est le n ième polynôme d’Hermite (probabiliste) . [23]

- La probabilité qu’une variable distribuée normalement X {displaystyle X}

avec connu μ {displaystylemu}

et σ {displaystylesigma}

est dans un ensemble particulier, peut être calculé en utilisant le fait que la fraction Z = ( X − μ ) / σ {displaystyle Z=(X-mu )/sigma}

a une distribution normale standard.

Des moments

Les moments simples et absolus d’une variable X {displaystyle X}

.

Si X {displaystyle X}

a une distribution normale, les moments non centraux existent et sont finis pour tout p {displaystyle p}

dont la partie réelle est supérieure à −1. Pour tout entier non négatif p {displaystyle p}

, les moments centraux simples sont : [24]

E [ ( X − μ ) p ] = { 0 if p is odd, σ p ( p − 1 ) ! ! if p is even. {displaystyle operatorname {E} left[(X-mu )^{p}right]={begin{cases}0&{text{if}}p{text{ est impair,}} \sigma ^{p}(p-1) !!&{text{if }}p{text{ est pair.}}end{cases}}} ![{displaystyle operatorname {E} left[(X-mu )^{p}right]={begin{cases}0&{text{if }}p{text{ is odd,}}\sigma ^{p}(p-1)!!&{text{if }}p{text{ is even.}}end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f1d2c92b62ac2bbe07a8e475faac29c8cc5f7755)

Ici n ! ! {displaystyle n !!}

désigne la factorielle double , c’est-à-dire le produit de tous les nombres de n {displaystyle n}

à 1 qui ont la même parité que n . {displaystyle n.}

Les moments centraux absolus coïncident avec les moments simples pour tous les ordres pairs, mais sont différents de zéro pour les ordres impairs. Pour tout entier non négatif p , {displaystyle p,}

E [ | X − μ | p ] = σ p ( p − 1 ) ! ! ⋅ { 2 π if p is odd 1 if p is even = σ p ⋅ 2 p / 2 Γ ( p + 1 2 ) π . {displaystyle {begin{aligned}operatorname {E} left[|X-mu |^{p}right]&=sigma ^{p}(p-1) !!cdot {begin {cases}{sqrt {frac {2}{pi }}}&{text{if }}p{text{ est impair}}\1&{text{if }}p{text{ est pair}}end{cases}}\&=sigma ^{p}cdot {frac {2^{p/2}Gamma left({frac {p+1}{2}} right)}{sqrt {pi }}}.end{aligned}}} ![{displaystyle {begin{aligned}operatorname {E} left[|X-mu |^{p}right]&=sigma ^{p}(p-1)!!cdot {begin{cases}{sqrt {frac {2}{pi }}}&{text{if }}p{text{ is odd}}\1&{text{if }}p{text{ is even}}end{cases}}\&=sigma ^{p}cdot {frac {2^{p/2}Gamma left({frac {p+1}{2}}right)}{sqrt {pi }}}.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3b196371c491676efa7ea7770ef56773db7652cd)

La dernière formule est également valable pour tout non entier p > − 1. {displaystyle p>-1.}

Quand la moyenne μ ≠ 0 , {displaystyle mu neq 0,}

les moments simples et absolus peuvent être exprimés en termes de fonctions hypergéométriques confluentes 1 F 1 {style d’affichage {}_{1}F_{1}}

et U . {displaystyle U.}

[ citation nécessaire ]

E [ X p ] = σ p ⋅ ( − i 2 ) p U ( − p 2 , 1 2 , − 1 2 ( μ σ ) 2 ) , E [ | X | p ] = σ p ⋅ 2 p / 2 Γ ( 1 + p 2 ) π 1 F 1 ( − p 2 , 1 2 , − 1 2 ( μ σ ) 2 ) . {displaystyle {begin{aligned}operatorname {E} left[X^{p}right]&=sigma ^{p}cdot (-i{sqrt {2}})^{p} Uleft(-{frac {p}{2}},{frac {1}{2}},-{frac {1}{2}}left({frac {mu }{ sigma }}right)^{2}right),\nomopérateur{E} left[|X|^{p}right]&=sigma ^{p}cdot 2^{p/2 }{frac {Gamma left({frac {1+p}{2}}right)}{sqrt {pi }}}{}_{1}F_{1}left(-{ frac {p}{2}},{frac {1}{2}},-{frac {1}{2}}left({frac {mu }{sigma }}right) ^{2}right).end{aligned}}} ![{displaystyle {begin{aligned}operatorname {E} left[X^{p}right]&=sigma ^{p}cdot (-i{sqrt {2}})^{p}Uleft(-{frac {p}{2}},{frac {1}{2}},-{frac {1}{2}}left({frac {mu }{sigma }}right)^{2}right),\operatorname {E} left[|X|^{p}right]&=sigma ^{p}cdot 2^{p/2}{frac {Gamma left({frac {1+p}{2}}right)}{sqrt {pi }}}{}_{1}F_{1}left(-{frac {p}{2}},{frac {1}{2}},-{frac {1}{2}}left({frac {mu }{sigma }}right)^{2}right).end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0c17bf881593b86e728bf5dfbdb41a4b86da3875)

Ces expressions restent valables même si p {displaystyle p}

n’est pas un entier. Voir aussi polynômes d’Hermite généralisés .

| Commande | Moment non central | Moment central |

|---|---|---|

| 1 | μ {displaystylemu}  |

0 {displaystyle 0}  |

| 2 | μ 2 + σ 2 {displaystyle mu ^{2}+sigma ^{2}}  |

σ 2 {displaystyle sigma ^{2}}  |

| 3 | μ 3 + 3 μ σ 2 {displaystyle mu ^{3}+3mu sigma ^{2}}  |

0 {displaystyle 0}  |

| 4 | μ 4 + 6 μ 2 σ 2 + 3 σ 4 {displaystyle mu ^{4}+6mu ^{2}sigma ^{2}+3sigma ^{4}}  |

3 σ 4 {displaystyle 3sigma ^{4}}  |

| 5 | μ 5 + 10 μ 3 σ 2 + 15 μ σ 4 {displaystyle mu ^{5}+10mu ^{3}sigma ^{2}+15mu sigma ^{4}}  |

0 {displaystyle 0}  |

| 6 | μ 6 + 15 μ 4 σ 2 + 45 μ 2 σ 4 + 15 σ 6 {displaystyle mu ^{6}+15mu ^{4}sigma ^{2}+45mu ^{2}sigma ^{4}+15sigma ^{6}}  |

15 σ 6 {displaystyle 15sigma ^{6}}  |

| 7 | μ 7 + 21 μ 5 σ 2 + 105 μ 3 σ 4 + 105 μ σ 6 {displaystyle mu ^{7}+21mu ^{5}sigma ^{2}+105mu ^{3}sigma ^{4}+105mu sigma ^{6}}  |

0 {displaystyle 0}  |

| 8 | μ 8 + 28 μ 6 σ 2 + 210 μ 4 σ 4 + 420 μ 2 σ 6 + 105 σ 8 {displaystyle mu ^{8}+28mu ^{6}sigma ^{2}+210mu ^{4}sigma ^{4}+420mu ^{2}sigma ^{6 }+105sigma ^{8}}  |

105 σ 8 {displaystyle 105sigma ^{8}}  |

Si la variable aléatoire X {displaystyle X}

est normalement distribué avec une moyenne μ {displaystylemu}

et variance finie non nulle σ 2 {displaystyle sigma ^{2}}

, Puis pour 0 < δ < 1 {displaystyle 0<delta <1}

la valeur attendue de l’inverse de la valeur absolue de X {displaystyle X}

est

E [ 1 | X | δ ] ≤ 2 ( 1 − δ ) 2 Γ ( 1 − δ 2 ) σ δ 2 π . {displaystyle {begin{aligned}operatorname {E} left[{frac {1}{vert Xvert ^{delta }}}right]&leq 2^{frac {(1 -delta )}{2}}{frac {Gamma left({frac {1-delta }{2}}right)}{sigma ^{delta }{sqrt {2pi }}}}.end{aligné}}} ![{displaystyle {begin{aligned}operatorname {E} left[{frac {1}{vert Xvert ^{delta }}}right]&leq 2^{frac {(1-delta )}{2}}{frac {Gamma left({frac {1-delta }{2}}right)}{sigma ^{delta }{sqrt {2pi }}}}.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bcc5467c139134a51dc620c0487904ded31d2bdf)

[25]

L’attente de X {displaystyle X}

conditionnée à l’événement que X {displaystyle X}

se situe dans un intervalle [ a , b ] {displaystyle [a,b]}

![[a,b]](https://wikimedia.org/api/rest_v1/media/math/render/svg/9c4b788fc5c637e26ee98b45f89a5c08c85f7935)

est donné par

E [ X ∣ a < X < b ] = μ − σ 2 f ( b ) − f ( a ) F ( b ) − F ( a ) {displaystyle operatorname {E} left[Xmid a<X<bright]=mu -sigma ^{2}{frac {f(b)-f(a)}{F(b )-FA)}}} ![{displaystyle operatorname {E} left[Xmid a<X<bright]=mu -sigma ^{2}{frac {f(b)-f(a)}{F(b)-F(a)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d82ec10bf31f0b63137699ae6e2b5a346770b097)

où f {displaystyle f}

et F {displaystyle F}

sont respectivement la densité et la fonction de distribution cumulative de X {displaystyle X}

. Pour b = ∞ {displaystyle b=infty}

c’est ce qu’on appelle le rapport de Mills inverse . Notez que ci-dessus, la densité f {displaystyle f}

de X {displaystyle X}

est utilisé à la place de la densité normale standard comme dans le rapport de Mills inverse, nous avons donc ici σ 2 {displaystyle sigma ^{2}}

à la place de σ {displaystylesigma}

.

Transformée de Fourier et fonction caractéristique

La transformée de Fourier d’une densité normale f {displaystyle f}

avec moyenne μ {displaystylemu}

et écart-type σ {displaystylesigma}

est [26]

f ^ ( t ) = ∫ − ∞ ∞ f ( x ) e − i t x d x = e − i μ t e − 1 2 ( σ t ) 2 {displaystyle {hat {f}}(t)=int _{-infty }^{infty}f(x)e^{-itx},dx=e^{-imu t} e^{-{frac {1}{2}}(sigma t)^{2}}}

où i {displaystyle i}

est une fonction propre de la transformée de Fourier.

En théorie des probabilités , la transformée de Fourier de la distribution de probabilité d’une variable aléatoire à valeur réelle X {displaystyle X}

est étroitement liée à la fonction caractéristique φ X ( t ) {displaystyle varphi _{X}(t)}

de cette variable, qui est définie comme la valeur attendue de e i t X {displaystyle e^{itX}}

, en fonction de la variable réelle t {displaystyle t}

(le paramètre de fréquence de la transformée de Fourier). Cette définition peut être étendue analytiquement à une variable à valeur complexe t {displaystyle t}

. [27] La relation entre les deux est :

φ X ( t ) = f ^ ( − t ) {displaystyle varphi _{X}(t)={hat {f}}(-t)}

Fonctions génératrices de moment et de cumulant

La fonction génératrice de moment d’une variable aléatoire réelle X {displaystyle X}

est la valeur attendue de e t X {displaystyle e^{tX}}

, en fonction du paramètre réel t {displaystyle t}

. Pour une distribution normale de densité f {displaystyle f}

, moyenne μ {displaystylemu}

et déviation σ {displaystylesigma}

, la fonction génératrice des moments existe et est égale à

M ( t ) = E [ e t X ] = f ^ ( i t ) = e μ t e 1 2 σ 2 t 2 {displaystyle M(t)=operatorname {E} [e^{tX}]={hat {f}}(it)=e^{mu t}e^{{tfrac {1}{2 }}sigma ^{2}t^{2}}} ![{displaystyle M(t)=operatorname {E} [e^{tX}]={hat {f}}(it)=e^{mu t}e^{{tfrac {1}{2}}sigma ^{2}t^{2}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/04bbd225c0fee5e58e9a8cd73b0f1b2bf535dc56)

La fonction génératrice cumulante est le logarithme de la fonction génératrice du moment, à savoir

g ( t ) = ln M ( t ) = μ t + 1 2 σ 2 t 2 {displaystyle g(t)=ln M(t)=mu t+{tfrac {1}{2}}sigma ^{2}t^{2}}

Comme il s’agit d’un polynôme quadratique en t {displaystyle t}

, seuls les deux premiers cumulants sont non nuls, à savoir la moyenne μ {displaystylemu}

et la variance σ 2 {displaystyle sigma ^{2}}

.

Opérateur et classe de Stein

Dans la méthode de Stein, l’opérateur et la classe de Stein d’une variable aléatoire X ∼ N ( μ , σ 2 ) {displaystyle Xsim {mathcal {N}}(mu ,sigma ^{2})}

sont A f ( x ) = σ 2 f ′ ( x ) − ( x − μ ) f ( x ) {displaystyle {mathcal {A}}f(x)=sigma ^{2}f'(x)-(x-mu )f(x)}

et F {displaystyle {mathcal {F}}}

la classe de toutes les fonctions absolument continues f : R → R such that E [ | f ′ ( X ) | ] < ∞ {displaystyle f:mathbb {R} to mathbb {R} {mbox{ tel que }}mathbb {E} [|f'(X)|]<infty }

![{displaystyle f:mathbb {R} to mathbb {R} {mbox{ such that }}mathbb {E} [|f'(X)|]<infty }](https://wikimedia.org/api/rest_v1/media/math/render/svg/69d73a6b7e591a67eaff64aaf974a8c37584626e)

.

Limite de variance nulle

A la limite quand σ {displaystylesigma}

tend vers zéro, la densité de probabilité f ( x ) {displaystyle f(x)}

tend finalement vers zéro à tout moment x ≠ μ {displaystyle xneq mu }

Cependant, on peut définir la distribution normale à variance nulle comme une fonction généralisée ; spécifiquement, comme la “fonction delta” de Dirac δ {displaystyledelta}

traduit par le moyen μ {displaystylemu}

, C’est f ( x ) = δ ( x − μ ) . {displaystyle f(x)=delta (x-mu ).}

Sa CDF est alors la fonction échelon de Heaviside traduite par la moyenne μ {displaystylemu}

, à savoir

F ( x ) = { 0 if x < μ 1 if x ≥ μ {displaystyle F(x)={begin{cases}0&{text{if }}x<mu \1&{text{if }}xgeq mu end{cases}}}

Entropie maximale

De toutes les distributions de probabilité sur les réels avec une moyenne spécifiée μ {displaystylemu}

et variance σ 2 {displaystyle sigma ^{2}}

, la distribution normale N ( μ , σ 2 ) {displaystyle N(mu ,sigma ^{2})}

est celui qui a le maximum d’entropie . [28] Si X {displaystyle X}

est une variable aléatoire continue de densité de probabilité f ( x ) {displaystyle f(x)}

, alors l’entropie de X {displaystyle X}

est défini comme [29] [30] [31]

H ( X ) = − ∫ − ∞ ∞ f ( x ) log f ( x ) d x {displaystyle H(X)=-int _{-infty}^{infty}f(x)log f(x),dx}

où f ( x ) log f ( x ) {displaystyle f(x)log f(x)}

est compris comme nul chaque fois que f ( x ) = 0 {displaystyle f(x)=0}

. Cette fonctionnelle peut être maximisée, sous réserve que la distribution soit correctement normalisée et ait une variance spécifiée, en utilisant le calcul variationnel . Une fonction à deux multiplicateurs de Lagrange est définie :

L = ∫ − ∞ ∞ f ( x ) ln ( f ( x ) ) d x − λ 0 ( 1 − ∫ − ∞ ∞ f ( x ) d x ) − λ ( σ 2 − ∫ − ∞ ∞ f ( x ) ( x − μ ) 2 d x ) {displaystyle L=int _{-infty}^{infty}f(x)ln(f(x)),dx-lambda _{0}left(1-int _{- infty }^{infty }f(x),dxright)-lambda left(sigma ^{2}-int _{-infty }^{infty }f(x)(x -mu )^{2},dxright)}

où f ( x ) {displaystyle f(x)}

est, pour l’instant, considérée comme une fonction de densité de moyenne μ {displaystylemu}

et écart-type σ {displaystylesigma}

.

A l’entropie maximale, une petite variation δ f ( x ) {displaystyle delta f(x)}

à propos f ( x ) {displaystyle f(x)}

produira une variation δ L {displaystyledelta L}

à propos L {displaystyle L}

qui est égal à 0 :

0 = δ L = ∫ − ∞ ∞ δ f ( x ) ( ln ( f ( x ) ) + 1 + λ 0 + λ ( x − μ ) 2 ) d x {displaystyle 0=delta L=int _{-infty}^{infty}delta f(x)left(ln(f(x))+1+lambda _{0}+ lambda (x-mu )^{2}right),dx}

Comme cela doit être vrai pour tout petit δ f ( x ) {displaystyle delta f(x)}

, le terme entre parenthèses doit être zéro, et résoudre pour f ( x ) {displaystyle f(x)}

donne :

f ( x ) = e − λ 0 − 1 − λ ( x − μ ) 2 {displaystyle f(x)=e^{-lambda _{0}-1-lambda (x-mu )^{2}}}

Utilisation des équations de contrainte pour résoudre λ 0 {style d’affichage lambda _{0}}

f ( x , μ , σ ) = 1 2 π σ 2 e − ( x − μ ) 2 2 σ 2 {displaystyle f(x,mu ,sigma )={frac {1}{sqrt {2pi sigma ^{2}}}}e^{-{frac {(x-mu ) ^{2}}{2sigma ^{2}}}}}

L’entropie d’une distribution normale est égale à

H ( X ) = 1 2 ( 1 + log ( 2 σ 2 π ) ) {displaystyle H(X)={tfrac {1}{2}}(1+log(2sigma ^{2}pi ))}

Autres propriétés

- Si la fonction caractéristique φ X {displaystyle phi _{X}}

d’une variable aléatoire X {displaystyle X}

est de la forme φ X ( t ) = exp Q ( t ) {displaystyle phi _{X}(t)=exp ^{Q(t)}}

, où Q ( t ) {displaystyle Q(t)}

est un polynôme , alors le théorème de Marcinkiewicz (du nom de Józef Marcinkiewicz ) affirme que Q {displaystyle Q}

peut être au plus un polynôme quadratique, et donc X {displaystyle X}

est une variable aléatoire normale. [32] La conséquence de ce résultat est que la distribution normale est la seule distribution avec un nombre fini (deux) de cumulants non nuls .

- Si X {displaystyle X}

et Y {displaystyle Y}

sont conjointement normaux et non corrélés , alors ils sont indépendants . L’exigence que X {displaystyle X}

et Y {displaystyle Y}

devrait être conjointement normal est essentiel ; sans elle la propriété ne tient pas. [33] [34] [preuve] Pour les variables aléatoires non normales, la non-corrélation n’implique pas l’indépendance.

- La divergence Kullback – Leibler d’une distribution normale X 1 ∼ N ( μ 1 , σ 1 2 ) {displaystyle X_{1}sim N(mu _{1},sigma _{1}^{2})}

D’un autre X 2 ∼ N ( μ 2 , σ 2 2 ) {displaystyle X_{2}sim N(mu _{2},sigma _{2}^{2})}

est donné par : [35] D K L ( X 1 ‖ X 2 ) = ( μ 1 − μ 2 ) 2 2 σ 2 2 + 1 2 ( σ 1 2 σ 2 2 − 1 − ln σ 1 2 σ 2 2 ) {displaystyle D_{mathrm {KL}}(X_{1},|,X_{2})={frac {(mu _{1}-mu _{2})^{2 }}{2sigma _{2}^{2}}}+{frac {1}{2}}left({frac {sigma _{1}^{2}}{sigma _{ 2}^{2}}}-1-ln {frac {sigma _{1}^{2}}{sigma _{2}^{2}}}right)}

La distance Hellinger entre les mêmes distributions est égale à H 2 ( X 1 , X 2 ) = 1 − 2 σ 1 σ 2 σ 1 2 + σ 2 2 e − 1 4 ( μ 1 − μ 2 ) 2 σ 1 2 + σ 2 2 {displaystyle H^{2}(X_{1},X_{2})=1-{sqrt {frac {2sigma _{1}sigma _{2}}{sigma _{1} ^{2}+sigma _{2}^{2}}}}e^{-{frac {1}{4}}{frac {(mu _{1}-mu _{2} )^{2}}{sigma _{1}^{2}+sigma _{2}^{2}}}}}

- La matrice d’information de Fisher pour une distribution normale est diagonale et prend la forme I = ( 1 σ 2 0 0 1 2 σ 4 ) {displaystyle {mathcal {I}}={begin{pmatrix}{frac {1}{sigma ^{2}}}&0\0&{frac {1}{2sigma ^{4} }}end{pmatrix}}}

- L’ a priori conjugué de la moyenne d’une distribution normale est une autre distribution normale. [36] Plus précisément, si x 1 , … , x n {displaystyle x_{1},ldots ,x_{n}}

sont iid ∼ N ( μ , σ 2 ) {displaystyle sim N(mu ,sigma ^{2})}

et le prior est μ ∼ N ( μ 0 , σ 0 2 ) {displaystyle mu sim N(mu _{0},sigma _{0}^{2})}

, alors la distribution a posteriori pour l’estimateur de μ {displaystylemu}

sera μ ∣ x 1 , … , x n ∼ N ( σ 2 n μ 0 + σ 0 2 x ̄ σ 2 n + σ 0 2 , ( n σ 2 + 1 σ 0 2 ) − 1 ) {displaystyle mu mid x_{1},ldots ,x_{n}sim {mathcal {N}}left({frac {{frac {sigma ^{2}}{n}} mu _{0}+sigma _{0}^{2}{bar {x}}}{{frac {sigma ^{2}}{n}}+sigma _{0}^{ 2}}},left({frac {n}{sigma ^{2}}}+{frac {1}{sigma _{0}^{2}}}right)^{-1 }à droite)}

- La famille des distributions normales forme non seulement une famille exponentielle (EF), mais forme en fait une famille exponentielle naturelle (NEF) avec quadratique fonction de variance quadratique ( NEF-QVF ). De nombreuses propriétés des distributions normales se généralisent aux propriétés des distributions NEF-QVF, des distributions NEF ou des distributions EF en général. Les distributions NEF-QVF comprennent 6 familles, y compris les distributions de Poisson, Gamma, binomiales et binomiales négatives, tandis que de nombreuses familles courantes étudiées en probabilités et statistiques sont NEF ou EF.

- En géométrie de l’information , la famille des distributions normales forme une variété statistique à courbure constante − 1 {displaystyle -1}

. La même famille est plate par rapport aux (±1)-connexions ∇ ( e ) {displaystyle nabla ^{(e)}}

et ∇ ( m ) {displaystyle nabla ^{(m)}}

. [37]

Distributions associées

Théorème central limite

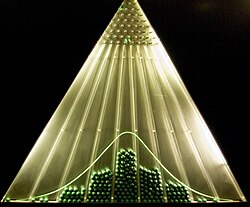

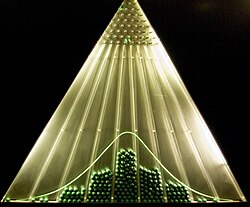

À mesure que le nombre d’événements discrets augmente, la fonction commence à ressembler à une distribution normale

À mesure que le nombre d’événements discrets augmente, la fonction commence à ressembler à une distribution normale

Comparaison des fonctions de densité de probabilité, p ( k ) {displaystyle p(k)}

Comparaison des fonctions de densité de probabilité, p ( k ) {displaystyle p(k)}

pour la somme de n {displaystyle n}

dés à 6 faces justes pour montrer leur convergence vers une distribution normale avec n a {displaystyle na}

, conformément au théorème central limite. Dans le graphique en bas à droite, les profils lissés des graphiques précédents sont redimensionnés, superposés et comparés à une distribution normale (courbe noire).

Le théorème central limite stipule que sous certaines conditions (assez courantes), la somme de nombreuses variables aléatoires aura une distribution approximativement normale. Plus précisément, où X 1 , … , X n {displaystyle X_{1},ldots ,X_{n}}

sont des variables aléatoires indépendantes et distribuées de manière identique avec la même distribution arbitraire, la même moyenne nulle et la même variance σ 2 {displaystyle sigma ^{2}}

et Z {displaystyle Z}

est leur moyenne mise à l’échelle par n {displaystyle {sqrt {n}}}

Z = n ( 1 n ∑ i = 1 n X i ) {displaystyle Z={sqrt {n}}left({frac {1}{n}}sum _{i=1}^{n}X_{i}right)}

Ensuite, comme n {displaystyle n}

augmente, la distribution de probabilité de Z {displaystyle Z}

tendra vers la distribution normale avec une moyenne et une variance nulles σ 2 {displaystyle sigma ^{2}}

.

Le théorème peut être étendu aux variables ( X i ) {displaystyle (X_{i})}

qui ne sont pas indépendants et/ou pas identiquement distribués si certaines contraintes sont posées sur le degré de dépendance et les moments des distributions.

De nombreuses statistiques de test , scores et estimateurs rencontrés dans la pratique contiennent des sommes de certaines variables aléatoires, et encore plus d’estimateurs peuvent être représentés comme des sommes de variables aléatoires grâce à l’utilisation de fonctions d’influence . Le théorème central limite implique que ces paramètres statistiques auront des distributions asymptotiquement normales.

Le théorème central limite implique également que certaines distributions peuvent être approchées par la distribution normale, par exemple :

- La distribution binomiale B ( n , p ) {displaystyle B(n,p)}

est approximativement normal avec une moyenne n p {displaystyle np}

et variance n p ( 1 − p ) {displaystyle np(1-p)}

pour les grands n {displaystyle n}

et pour p {displaystyle p}

pas trop proche de 0 ou 1.

- La distribution de Poisson de paramètre λ {displaystylelambda}

est approximativement normal avec une moyenne λ {displaystylelambda}

et variance λ {displaystylelambda}

, pour les grandes valeurs de λ {displaystylelambda}

. [38]

- La distribution du chi carré χ 2 ( k ) {displaystyle chi ^{2}(k)}

est approximativement normal avec une moyenne k {displaystyle k}

et variance 2 k {displaystyle 2k}

, pour les grands k {displaystyle k}

.

- La distribution t de Student t ( ν ) {displaystyle t(nu )}

est approximativement normal avec une moyenne de 0 et une variance de 1 lorsque ν {displaystylenu }

est large.

La précision de ces approximations dépend de l’objectif pour lequel elles sont nécessaires et du taux de convergence vers la distribution normale. Il arrive généralement que de telles approximations soient moins précises dans les queues de la distribution.

Une limite supérieure générale pour l’erreur d’approximation dans le théorème central limite est donnée par le théorème de Berry-Esseen , des améliorations de l’approximation sont données par les développements d’Edgeworth .

Ce théorème peut également être utilisé pour justifier la modélisation de la somme de nombreuses sources de bruit uniformes sous forme de bruit gaussien . Voir AWGN .

Opérations et fonctions des variables normales

a : Densité de probabilité d’une fonction cos x 2 { style d’affichage cos x ^ {2}}

a : Densité de probabilité d’une fonction cos x 2 { style d’affichage cos x ^ {2}}

d’une variable normale x {style d’affichage x}

avec μ = − 2 {displaystylemu =-2}

et σ = 3 {displaystylesigma =3}

. b : Densité de probabilité d’une fonction x y {displaystyle x^{y}}

de deux variables normales x {style d’affichage x}

et y {displaystyle y}

, où μ x = 1 {displaystylemu _{x}=1}

, μ y = 2 {displaystylemu _{y}=2}

, σ x = 0.1 {displaystylesigma _{x}=0.1}

, σ y = 0.2 {displaystylesigma _{y}=0.2}

, et ρ x y = 0.8 {displaystyle rho _{xy}=0.8}

. c : carte thermique de la densité de probabilité conjointe de deux fonctions de deux variables normales corrélées x {style d’affichage x}

et y {displaystyle y}

, où μ x = − 2 {displaystylemu _{x}=-2}

, μ y = 5 {displaystylemu _{y}=5}

, σ x 2 = 10 {displaystylesigma _{x}^{2}=10}

, σ y 2 = 20 {displaystylesigma _{y}^{2}=20}

, et ρ x y = 0.495 {displaystyle rho _{xy}=0,495}

. d : Densité de probabilité d’une fonction ∑ i = 1 4 | x i | {textstyle sum _{i=1}^{4}vert x_{i}vert }

de 4 iid variables normales standard. Celles-ci sont calculées par la méthode numérique du lancer de rayons. [39]

La densité de probabilité , la distribution cumulative et la distribution cumulative inverse de toute fonction d’une ou plusieurs variables normales indépendantes ou corrélées peuvent être calculées avec la méthode numérique du lancer de rayons [39] ( code Matlab ). Dans les sections suivantes, nous examinons quelques cas particuliers.

Opérations sur une seule variable normale

Si X {displaystyle X}

est distribué normalement avec une moyenne μ {displaystylemu}

et variance σ 2 {displaystyle sigma ^{2}}

, alors

- a X + b {displaystyle aX+b}

, pour tout nombre réel a {displaystyle a}

et b {displaystyle b}

, est également distribué normalement, avec une moyenne a μ + b {displaystyle amu +b}

et écart-type | a | σ {displaystyle |a|sigma }

. Autrement dit, la famille des distributions normales est fermée sous les transformations linéaires.

- L’exponentielle de X {displaystyle X}

est distribué log-normalement : e X ~ ln( N ( μ , σ 2 )) .

- La valeur absolue de X {displaystyle X}

a une distribution normale pliée : | X | ~ N f ( μ , σ 2 ) . Si μ = 0 {displaystylemu =0}

c’est ce qu’on appelle la distribution semi-normale .

- La valeur absolue des résidus normalisés, | X − μ |/ σ , a une distribution chi à un degré de liberté : | X − μ | / σ ∼ χ 1 {displaystyle |X-mu |/sigma sim chi _{1}}

.

- Le carré de X / σ a la distribution chi carré non centrale avec un degré de liberté : X 2 / σ 2 ∼ χ 1 2 ( μ 2 / σ 2 ) {textstyle X^{2}/sigma ^{2}sim chi _{1}^{2}(mu ^{2}/sigma ^{2})}

. Si μ = 0 {displaystylemu =0}

, la distribution est appelée simplement chi carré .

- Le log de vraisemblance d’une variable normale x {style d’affichage x}

est simplement le logarithme de sa fonction de densité de probabilité : ln p ( x ) = − 1 2 ( x − μ σ ) 2 − ln ( σ 2 π ) = − 1 2 z 2 − ln ( σ 2 π ) . {displaystyle ln p(x)=-{frac {1}{2}}left({frac {x-mu }{sigma }}right)^{2}-ln left (sigma {sqrt {2pi }}right)=-{frac {1}{2}}z^{2}-ln left(sigma {sqrt {2pi }} à droite).}

Puisqu’il s’agit d’un carré mis à l’échelle et décalé d’une variable normale standard, il est distribué comme une variable chi carré mise à l’échelle et décalée .

- La distribution de la variable X restreinte à un intervalle [ a , b ] est appelée distribution normale tronquée .

- ( X − μ ) −2 a une distribution de Lévy de position 0 et d’échelle σ −2 .

Opérations sur deux variables normales indépendantes

- Si X 1 {displaystyle X_{1}}

et X 2 {displaystyle X_{2}}

sont deux variables aléatoires normales indépendantes , avec des moyennes μ 1 {displaystylemu _{1}}

, μ 2 {displaystylemu _{2}}

et écarts types σ 1 {displaystyle sigma _{1}}

, σ 2 {displaystyle sigma _{2}}

, alors leur somme X 1 + X 2 {displaystyle X_{1}+X_{2}}

sera également distribué normalement, [preuve] avec une moyenne μ 1 + μ 2 {displaystyle mu _{1}+mu _{2}}

et variance σ 1 2 + σ 2 2 {displaystyle sigma _{1}^{2}+sigma _{2}^{2}}

.

- En particulier, si X {displaystyle X}

et Y {displaystyle Y}

sont des écarts normaux indépendants avec une moyenne et une variance nulles σ 2 {displaystyle sigma ^{2}}

, alors X + Y {displaystyle X+Y}

et X − Y {style d’affichage XY}

sont également indépendants et normalement distribués, avec une moyenne et une variance nulles 2 σ 2 {displaystyle 2sigma ^{2}}

. C’est un cas particulier de l’ identité de polarisation . [40]

- Si X 1 {displaystyle X_{1}}

, X 2 {displaystyle X_{2}}

sont deux écarts normaux indépendants de moyenne μ {displaystylemu}

et déviation σ {displaystylesigma}

, et a {displaystyle a}

, b {displaystyle b}

sont des nombres réels arbitraires, alors la variable X 3 = a X 1 + b X 2 − ( a + b ) μ a 2 + b 2 + μ {displaystyle X_{3}={frac {aX_{1}+bX_{2}-(a+b)mu }{sqrt {a^{2}+b^{2}}}}+ mu }

est aussi normalement distribué avec une moyenne μ {displaystylemu}

et déviation σ {displaystylesigma}

. Il s’ensuit que la distribution normale est stable (d’exposant α = 2 {displaystylealpha =2}

).

Opérations sur deux variables normales standard indépendantes

Si X 1 {displaystyle X_{1}}

- Leur somme et leur différence sont distribuées normalement avec une moyenne nulle et une variance deux : X 1 ± X 2 ∼ N ( 0 , 2 ) {displaystyle X_{1}pm X_{2}sim N(0,2)}

.

- Leur produit Z = X 1 X 2 {displaystyle Z=X_{1}X_{2}}

suit la distribution du produit [41] avec la fonction de densité f Z ( z ) = π − 1 K 0 ( | z | ) {displaystyle f_{Z}(z)=pi ^{-1}K_{0}(|z|)}

où K 0 {displaystyle K_{0}}

est la fonction de Bessel modifiée de seconde espèce . Cette distribution est symétrique autour de zéro, illimitée en z = 0 {style d’affichage z=0}

, et a la fonction caractéristique φ Z ( t ) = ( 1 + t 2 ) − 1 / 2 {displaystyle phi _{Z}(t)=(1+t^{2})^{-1/2}}

.

- Leur rapport suit la distribution standard de Cauchy : X 1 / X 2 ∼ Cauchy ( 0 , 1 ) {displaystyle X_{1}/X_{2}sim operatorname {Cauchy} (0,1)}

.

- Leur norme euclidienne X 1 2 + X 2 2 {displaystyle {sqrt {X_{1}^{2}+X_{2}^{2}}}}

a la distribution de Rayleigh .

Opérations sur plusieurs variables normales indépendantes

- Toute combinaison linéaire d’écarts normaux indépendants est un écart normal.

- Si X 1 , X 2 , … , X n {displaystyle X_{1},X_{2},ldots ,X_{n}}

sont des variables aléatoires normales standard indépendantes, alors la somme de leurs carrés a la distribution du chi carré avec n {displaystyle n}

degrés de liberté X 1 2 + ⋯ + X n 2 ∼ χ n 2 . {displaystyle X_{1}^{2}+cdots +X_{n}^{2}sim chi _{n}^{2}.}

- Si X 1 , X 2 , … , X n {displaystyle X_{1},X_{2},ldots ,X_{n}}

sont des variables aléatoires indépendantes normalement distribuées avec des moyennes μ {displaystylemu}

et écarts σ 2 {displaystyle sigma ^{2}}

, alors leur moyenne d’échantillon est indépendante de l’ écart type d’échantillon , [42] qui peut être démontré en utilisant le théorème de Basu ou le théorème de Cochran . [43] Le rapport de ces deux quantités aura la distribution t de Student avec n − 1 {displaystyle n-1}

degrés de liberté: t = X ̄ − μ S / n = 1 n ( X 1 + ⋯ + X n ) − μ 1 n ( n − 1 ) [ ( X 1 − X ̄ ) 2 + ⋯ + ( X n − X ̄ ) 2 ] ∼ t n − 1 . {displaystyle t={frac {{overline {X}}-mu }{S/{sqrt {n}}}}={frac {{frac {1}{n}}(X_{ 1}+cdots +X_{n})-mu }{sqrt {{frac {1}{n(n-1)}}left[(X_{1}-{overline {X}} )^{2}+cdots +(X_{n}-{overline {X}})^{2}right]}}}sim t_{n-1}.}

- Si X 1 , X 2 , … , X n {displaystyle X_{1},X_{2},ldots ,X_{n}}

, Y 1 , Y 2 , … , Y m {displaystyle Y_{1},Y_{2},ldots ,Y_{m}}

sont des variables aléatoires normales standard indépendantes, alors le rapport de leurs sommes de carrés normalisées aura la distribution F avec ( n , m ) degrés de liberté : [44] F = ( X 1 2 + X 2 2 + ⋯ + X n 2 ) / n ( Y 1 2 + Y 2 2 + ⋯ + Y m 2 ) / m ∼ F n , m . {displaystyle F={frac {left(X_{1}^{2}+X_{2}^{2}+cdots +X_{n}^{2}right)/n}{left (Y_{1}^{2}+Y_{2}^{2}+cdots +Y_{m}^{2}right)/m}}sim F_{n,m}.}

Opérations sur plusieurs variables normales corrélées

- Une forme quadratique d’un vecteur normal, c’est-à-dire une fonction quadratique q = ∑ x i 2 + ∑ x j + c {textstyle q=sum x_{i}^{2}+sum x_{j}+c}

de plusieurs variables normales indépendantes ou corrélées, est une variable chi carré généralisée .

Opérations sur la fonction de densité

La distribution normale divisée est définie le plus directement en termes de jonction de sections mises à l’échelle des fonctions de densité de différentes distributions normales et de remise à l’échelle de la densité pour l’intégrer à une. La distribution normale tronquée résulte de la remise à l’échelle d’une section d’une fonction de densité unique.

Divisibilité infinie et théorème de Cramér

Pour tout entier positif n {displaystyle {text{n}}}

, toute distribution normale de moyenne μ {displaystylemu}

et variance σ 2 {displaystyle sigma ^{2}}

est la distribution de la somme de n {displaystyle {text{n}}}

écarts normaux indépendants, chacun avec une moyenne μ n {displaystyle {frac {mu }{n}}}

et variance σ 2 n {displaystyle {frac {sigma ^{2}}{n}}}

. Cette propriété est appelée divisibilité infinie . [45]

A l’inverse, si X 1 {displaystyle X_{1}}

et X 2 {displaystyle X_{2}}

sont des variables aléatoires indépendantes et leur somme X 1 + X 2 {displaystyle X_{1}+X_{2}}

a une distribution normale, alors les deux X 1 {displaystyle X_{1}}

et X 2 {displaystyle X_{2}}

doit être des déviations normales. [46]

Ce résultat est connu sous le nom de théorème de décomposition de Cramér et équivaut à dire que la convolution de deux distributions est normale si et seulement si les deux sont normales. Le théorème de Cramér implique qu’une combinaison linéaire de variables non gaussiennes indépendantes n’aura jamais une distribution exactement normale, bien qu’elle puisse s’en approcher arbitrairement de près. [32]

Théorème de Bernstein

Le théorème de Bernstein stipule que si X {displaystyle X}

et Y {displaystyle Y}

sont indépendants et X + Y {displaystyle X+Y}

et X − Y {style d’affichage XY}

sont également indépendants, alors X et Y doivent nécessairement avoir des distributions normales. [47] [48]

Plus généralement, si X 1 , … , X n {displaystyle X_{1},ldots ,X_{n}}

sont des variables aléatoires indépendantes, alors deux combinaisons linéaires distinctes ∑ a k X k {textstyle sum {a_{k}X_{k}}}

et ∑ b k X k {textstyle sum {b_{k}X_{k}}}

seront indépendants si et seulement si tous X k {displaystyle X_{k}}

sont normaux et ∑ a k b k σ k 2 = 0 {textstyle sum {a_{k}b_{k}sigma _{k}^{2}=0}}

, où σ k 2 {displaystyle sigma _{k}^{2}}

désigne la variance de X k {displaystyle X_{k}}

. [47]

Rallonges

La notion de distribution normale, étant l’une des distributions les plus importantes de la théorie des probabilités, a été étendue bien au-delà du cadre standard du cas univarié (c’est-à-dire unidimensionnel) (cas 1). Toutes ces extensions sont également appelées lois normales ou gaussiennes , il existe donc une certaine ambiguïté dans les noms.

- La distribution normale multivariée décrit la loi gaussienne dans l’ espace euclidien de dimension k . Un vecteur X ∈ R k est multivarié-normalement distribué si toute combinaison linéaire de ses composantes Σk

j =1a j X j a une distribution normale (univariée). La variance de X est unematrice définie positive symétrique k×k V . La distribution normale multivariée est un cas particulier des distributions elliptiques . En tant que tel, ses lieux d’iso-densité dans le cas k = 2 sont des ellipses et dans le cas de k arbitrairesont des ellipsoïdes . - Distribution gaussienne rectifiée une version rectifiée de la distribution normale avec tous les éléments négatifs remis à 0

- La distribution normale complexe traite des vecteurs normaux complexes. Un vecteur complexe X ∈ C k est dit normal si ses composantes réelles et imaginaires possèdent conjointement une distribution normale multivariée à 2 k dimensions. La structure de variance-covariance de X est décrite par deux matrices : la matrice de variance Γ et la matrice de relation C .

- La distribution normale matricielle décrit le cas des matrices normalement distribuées.

- Les processus gaussiens sont les processus stochastiques normalement distribués . Ceux-ci peuvent être considérés comme des éléments d’un espace de Hilbert de dimension infinie H , et sont donc les analogues de vecteurs normaux multivariés pour le cas k = ∞ . Un élément aléatoire h ∈ H est dit normal si pour toute constante a ∈ H le produit scalaire ( a , h ) a une distribution normale (univariée). La structure de variance d’un tel élément aléatoire gaussien peut être décrite en termes d’opérateur de covariance linéaire K : H → H. Plusieurs processus gaussiens sont devenus suffisamment populaires pour avoir leur propre nom :

- mouvement brownien ,

- Pont brownien ,

- Processus d’Ornstein-Uhlenbeck .

- La distribution q gaussienne est une construction mathématique abstraite qui représente un ” q-analogue » de la distribution normale.

- la q-gaussienne est un analogue de la distribution gaussienne, en ce sens qu’elle maximise l’ entropie de Tsallis , et est un type de distribution de Tsallis . Notez que cette distribution est différente de la distribution q gaussienne ci- dessus.

Une variable aléatoire X a une distribution normale en deux parties si elle a une distribution

f X ( x ) = N ( μ , σ 1 2 ) if x ≤ μ {displaystyle f_{X}(x)=N(mu ,sigma _{1}^{2}){text{ if }}xleq mu }

f X ( x ) = N ( μ , σ 2 2 ) if x ≥ μ {displaystyle f_{X}(x)=N(mu ,sigma _{2}^{2}){text{ if }}xgeq mu }

où μ est la moyenne et σ 1 et σ 2 sont les écarts-types de la distribution à gauche et à droite de la moyenne respectivement.

La moyenne, la variance et le troisième moment central de cette distribution ont été déterminés [49]

E ( X ) = μ + 2 π ( σ 2 − σ 1 ) {displaystyle operatorname {E} (X)=mu +{sqrt {frac {2}{pi }}}(sigma _{2}-sigma _{1})}

V ( X ) = ( 1 − 2 π ) ( σ 2 − σ 1 ) 2 + σ 1 σ 2 {displaystyle operatorname {V} (X)=left(1-{frac {2}{pi }}right)(sigma _{2}-sigma _{1})^{2} +sigma _{1}sigma _{2}}

T ( X ) = 2 π ( σ 2 − σ 1 ) [ ( 4 π − 1 ) ( σ 2 − σ 1 ) 2 + σ 1 σ 2 ] {displaystyle operatorname {T} (X)={sqrt {frac {2}{pi }}}(sigma _{2}-sigma _{1})left[left({ frac {4}{pi }}-1right)(sigma _{2}-sigma _{1})^{2}+sigma _{1}sigma _{2}right]}

![{displaystyle operatorname {T} (X)={sqrt {frac {2}{pi }}}(sigma _{2}-sigma _{1})left[left({frac {4}{pi }}-1right)(sigma _{2}-sigma _{1})^{2}+sigma _{1}sigma _{2}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9959f2c5186e2ed76884054edaf837a602ac6fac)

où E( X ), V( X ) et T( X ) sont respectivement la moyenne, la variance et le troisième moment central.

L’une des principales utilisations pratiques de la loi gaussienne est de modéliser les distributions empiriques de nombreuses variables aléatoires différentes rencontrées dans la pratique. Dans ce cas, une extension possible serait une famille de distributions plus riche, ayant plus de deux paramètres et pouvant donc s’adapter plus précisément à la distribution empirique. Les exemples de telles extensions sont :

- Répartition de Pearson – une famille à quatre paramètres de distributions de probabilité qui étendent la loi normale pour inclure différentes valeurs d’asymétrie et d’aplatissement.

- La distribution normale généralisée , également connue sous le nom de distribution de puissance exponentielle, permet des queues de distribution avec des comportements asymptotiques plus épais ou plus fins.

Inférence statistique

Estimation des paramètres

Il arrive souvent que nous ne connaissions pas les paramètres de la distribution normale, mais que nous souhaitions plutôt les estimer . c’est-à-dire avoir un échantillon ( x 1 , … , x n ) {displaystyle (x_{1},ldots ,x_{n})}

d’une normale N ( μ , σ 2 ) {displaystyle N(mu ,sigma ^{2})}

population, nous aimerions connaître les valeurs approximatives des paramètres μ {displaystylemu}

et σ 2 {displaystyle sigma ^{2}}

. L’approche standard de ce problème est la méthode du maximum de vraisemblance , qui nécessite la maximisation de la fonction log-vraisemblance :

ln L ( μ , σ 2 ) = ∑ i = 1 n ln f ( x i ∣ μ , σ 2 ) = − n 2 ln ( 2 π ) − n 2 ln σ 2 − 1 2 σ 2 ∑ i = 1 n ( x i − μ ) 2 . {displaystyle ln {mathcal {L}}(mu ,sigma ^{2})=sum _{i=1}^{n}ln f(x_{i}mid mu , sigma ^{2})=-{frac {n}{2}}ln(2pi )-{frac {n}{2}}ln sigma ^{2}-{frac {1 }{2sigma ^{2}}}sum _{i=1}^{n}(x_{i}-mu )^{2}.}

Prendre des dérivées par rapport à μ {displaystylemu}

et σ 2 {displaystyle sigma ^{2}}

et la résolution du système résultant de conditions de premier ordre donne les estimations du maximum de vraisemblance :

μ ^ = x ̄ ≡ 1 n ∑ i = 1 n x i , σ ^ 2 = 1 n ∑ i = 1 n ( x i − x ̄ ) 2 . {displaystyle {hat {mu }}={overline {x}}equiv {frac {1}{n}}sum _{i=1}^{n}x_{i},qquad {hat {sigma }}^{2}={frac {1}{n}}sum _{i=1}^{n}(x_{i}-{overline {x}})^ {2}.}

Moyenne de l’échantillon

Estimateur μ ^ {displaystyle textstyle {hat {mu }}}

s’appelle la moyenne de l’échantillon , puisqu’il s’agit de la moyenne arithmétique de toutes les observations. La statistique x ̄ {displaystyle textstyle {overline {x}}}

est complet et suffisant pour μ {displaystylemu}

, et donc par le théorème de Lehmann–Scheffé , μ ^ {displaystyle textstyle {hat {mu }}}

est l’ estimateur uniforme sans biais de la variance minimale (UMVU). [50] Dans les échantillons finis, il est distribué normalement :

μ ^ ∼ N ( μ , σ 2 / n ) . {displaystyle {hat {mu }}sim {mathcal {N}}(mu ,sigma ^{2}/n).}

La variance de cet estimateur est égale à l’ élément μμ de la matrice d’information inverse de Fisher I − 1 {displaystyle textstyle {mathcal {I}}^{-1}}

. Cela implique que l’estimateur est efficace en échantillon fini . D’une importance pratique est le fait que l’ erreur type de μ ^ {displaystyle textstyle {hat {mu }}}

est proportionnel à 1 / n {displaystyle textstyle 1/{sqrt {n}}}

, c’est-à-dire que si l’on souhaite diminuer l’erreur type d’un facteur 10, il faut augmenter le nombre de points dans l’échantillon d’un facteur 100. Ce fait est largement utilisé pour déterminer la taille des échantillons pour les sondages d’opinion et le nombre de essais dans des simulations de Monte Carlo .

Du point de vue de la théorie asymptotique , μ ^ {displaystyle textstyle {hat {mu }}}

n ( μ ^ − μ ) → d N ( 0 , σ 2 ) . {displaystyle {sqrt {n}}({hat {mu}}-mu ),{xrightarrow {d}},{mathcal {N}}(0,sigma ^{2} ).}

Écart d’échantillon

L’estimateur σ ^ 2 {displaystyle textstyle {chapeau {sigma}}^{2}}

s’appelle la variance de l’échantillon , puisqu’il s’agit de la variance de l’échantillon ( ( x 1 , … , x n ) {displaystyle (x_{1},ldots ,x_{n})}

). En pratique, un autre estimateur est souvent utilisé à la place du σ ^ 2 {displaystyle textstyle {chapeau {sigma}}^{2}}

. Cet autre estimateur est noté s 2 {displaystyle s^{2}}

, et est également appelée la variance de l’échantillon , ce qui représente une certaine ambiguïté dans la terminologie ; sa racine carrée s {displaystyle s}

s’appelle l’ écart-type de l’échantillon . L’estimateur s 2 {displaystyle s^{2}}

diffère de σ ^ 2 {displaystyle textstyle {chapeau {sigma}}^{2}}

en ayant ( n − 1) au lieu de n au dénominateur (la soi-disant correction de Bessel ):

s 2 = n n − 1 σ ^ 2 = 1 n − 1 ∑ i = 1 n ( x i − x ̄ ) 2 . {displaystyle s^{2}={frac {n}{n-1}}{hat {sigma}}^{2}={frac {1}{n-1}}sum _{ i=1}^{n}(x_{i}-{overline {x}})^{2}.}

La différence entre s 2 {displaystyle s^{2}}

et σ ^ 2 {displaystyle textstyle {chapeau {sigma}}^{2}}

devient négligeable pour les grands n ‘s . Dans des échantillons finis cependant, la motivation derrière l’utilisation de s 2 {displaystyle s^{2}}

est qu’il s’agit d’un estimateur sans biais du paramètre sous-jacent σ 2 {displaystyle sigma ^{2}}

, tandis que σ ^ 2 {displaystyle textstyle {chapeau {sigma}}^{2}}

est biaisé. De plus, par le théorème de Lehmann – Scheffé, l’estimateur s 2 {displaystyle s^{2}}

est uniformément minimum variance sans biais (UMVU), [50] ce qui en fait le “meilleur” estimateur parmi tous les estimateurs sans biais. Cependant, on peut montrer que l’estimateur biaisé σ ^ 2 {displaystyle textstyle {chapeau {sigma}}^{2}}

est “meilleur” que le s 2 {displaystyle s^{2}}

en termes de critère d’erreur quadratique moyenne (MSE). Dans les échantillons finis, les deux s 2 {displaystyle s^{2}}

et σ ^ 2 {displaystyle textstyle {chapeau {sigma}}^{2}}

ont une distribution du chi carré à l’échelle avec ( n – 1) degrés de liberté :

s 2 ∼ σ 2 n − 1 ⋅ χ n − 1 2 , σ ^ 2 ∼ σ 2 n ⋅ χ n − 1 2 . {displaystyle s^{2}sim {frac {sigma ^{2}}{n-1}}cdot chi _{n-1}^{2},qquad {hat {sigma }}^{2}sim {frac {sigma ^{2}}{n}}cdot chi _{n-1}^{2}.}

La première de ces expressions montre que la variance de s 2 {displaystyle s^{2}}

est égal à 2 σ 4 / ( n − 1 ) {displaystyle 2sigma ^{4}/(n-1)}

, qui est légèrement supérieur à l’ élément σσ de la matrice d’information inverse de Fisher I − 1 {displaystyle textstyle {mathcal {I}}^{-1}}

. Ainsi, s 2 {displaystyle s^{2}}

n’est pas un estimateur efficace pour σ 2 {displaystyle sigma ^{2}}

, et de plus, puisque s 2 {displaystyle s^{2}}

est UMVU, nous pouvons conclure que l’estimateur efficace à échantillon fini pour σ 2 {displaystyle sigma ^{2}}

n’existe pas.

En appliquant la théorie asymptotique, les deux estimateurs s 2 {displaystyle s^{2}}

que la taille de l’échantillon n → ∞ {displaystyle nrightarrow infty}

. Les deux estimateurs sont également asymptotiquement normaux :

n ( σ ^ 2 − σ 2 ) ≃ n ( s 2 − σ 2 ) → d N ( 0 , 2 σ 4 ) . {displaystyle {sqrt {n}}({hat {sigma }}^{2}-sigma ^{2})simeq {sqrt {n}}(s^{2}-sigma ^ {2}),{xrightarrow {d}},{mathcal {N}}(0,2sigma ^{4}).}

En particulier, les deux estimateurs sont asymptotiquement efficaces pour σ 2 {displaystyle sigma ^{2}}

.

Intervalles de confiance

D’ après le théorème de Cochran , pour les distributions normales, la moyenne de l’échantillon μ ^ {displaystyle textstyle {hat {mu }}}

et les variances d’échantillon s 2 sont indépendantes , ce qui signifie qu’il ne peut y avoir aucun gain à considérer leur distribution conjointe . Il existe également un théorème inverse : si dans un échantillon la moyenne et la variance de l’échantillon sont indépendantes, alors l’échantillon doit provenir de la distribution normale. L’indépendance entre μ ^ {displaystyle textstyle {hat {mu }}}

et s peuvent être utilisés pour construire la soi-disant statistique t :

t = μ ^ − μ s / n = x ̄ − μ 1 n ( n − 1 ) ∑ ( x i − x ̄ ) 2 ∼ t n − 1 {displaystyle t={frac {{hat {mu }}-mu }{s/{sqrt {n}}}}={frac {{overline {x}}-mu }{ sqrt {{frac {1}{n(n-1)}}sum (x_{i}-{overline {x}})^{2}}}}sim t_{n-1}}

Cette quantité t a la distribution t de Student avec ( n − 1) degrés de liberté, et c’est une statistique auxiliaire (indépendante de la valeur des paramètres). L’inversion de la distribution de cette statistique t nous permettra de construire l’ intervalle de confiance pour μ ; [51] de même, l’inversion de la distribution χ 2 de la statistique s 2 nous donnera l’intervalle de confiance pour σ 2 : [52]

μ ∈ [ μ ^ − t n − 1 , 1 − α / 2 1 n s , μ ^ + t n − 1 , 1 − α / 2 1 n s ] , {displaystyle mu in left[{hat {mu }}-t_{n-1,1-alpha /2}{frac {1}{sqrt {n}}}s,{ chapeau {mu }}+t_{n-1,1-alpha /2}{frac {1}{sqrt {n}}}sright],} ![{displaystyle mu in left[{hat {mu }}-t_{n-1,1-alpha /2}{frac {1}{sqrt {n}}}s,{hat {mu }}+t_{n-1,1-alpha /2}{frac {1}{sqrt {n}}}sright],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f6e3068587bfbaf61a549a39b518757119bfb846)

σ 2 ∈ [ ( n − 1 ) s 2 χ n − 1 , 1 − α / 2 2 , ( n − 1 ) s 2 χ n − 1 , α / 2 2 ] , {displaystyle sigma ^{2}in left[{frac {(n-1)s^{2}}{chi _{n-1,1-alpha /2}^{2}} },{frac {(n-1)s^{2}}{chi _{n-1,alpha /2}^{2}}}right],}

![{displaystyle sigma ^{2}in left[{frac {(n-1)s^{2}}{chi _{n-1,1-alpha /2}^{2}}},{frac {(n-1)s^{2}}{chi _{n-1,alpha /2}^{2}}}right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3549a31cb861d9e479c232271cb88b019cfa9fd5)

où t k,p et χ 2

k,p sont les p ièmes quantiles des distributions t – et χ 2 respectivement. Ces intervalles de confiance sont du niveau de confiance 1 − α , ce qui signifie que les vraies valeurs μ et σ 2 se situent en dehors de ces intervalles avec probabilité (ou niveau de signification ) α . En pratique, les gens prennent généralement α = 5 % , ce qui donne des intervalles de confiance à 95%.

Des formules approximatives peuvent être dérivées des distributions asymptotiques de μ ^ {displaystyle textstyle {hat {mu }}}

et s 2 :

μ ∈ [ μ ^ − | z α / 2 | 1 n s , μ ^ + | z α / 2 | 1 n s ] , {displaystyle mu in left[{hat {mu }}-|z_{alpha /2}|{frac {1}{sqrt {n}}}s,{hat {mu }}+|z_{alpha /2}|{frac {1}{sqrt {n}}}sright],} ![{displaystyle mu in left[{hat {mu }}-|z_{alpha /2}|{frac {1}{sqrt {n}}}s,{hat {mu }}+|z_{alpha /2}|{frac {1}{sqrt {n}}}sright],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e13883f93c0a1405e71bd105685ecac6b4c84089)

σ 2 ∈ [ s 2 − | z α / 2 | 2 n s 2 , s 2 + | z α / 2 | 2 n s 2 ] , {displaystyle sigma ^{2}in left[s^{2}-|z_{alpha /2}|{frac {sqrt {2}}{sqrt {n}}}s^{ 2},s^{2}+|z_{alpha /2}|{frac {sqrt {2}}{sqrt {n}}}s^{2}right],}

![{displaystyle sigma ^{2}in left[s^{2}-|z_{alpha /2}|{frac {sqrt {2}}{sqrt {n}}}s^{2},s^{2}+|z_{alpha /2}|{frac {sqrt {2}}{sqrt {n}}}s^{2}right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e3e7c940eb3f6f50af62200ae75e10435ef8dfe6)

Les formules approchées deviennent valides pour les grandes valeurs de n , et sont plus pratiques pour le calcul manuel puisque les quantiles normaux standard z α /2 ne dépendent pas de n . En particulier, la valeur la plus populaire de α = 5% , donne | z 0,025 | = 1,96 .

Tests de normalité

Les tests de normalité évaluent la probabilité que l’ensemble de données donné { x 1 , …, x n } provienne d’une distribution normale. Typiquement, l’ hypothèse nulle H 0 est que les observations sont distribuées normalement avec une moyenne μ et une variance σ 2 non spécifiées , contre l’alternative H a que la distribution est arbitraire. De nombreux tests (plus de 40) ont été conçus pour ce problème. Les plus importants d’entre eux sont décrits ci-dessous:

Les diagrammes de diagnostic sont plus attrayants intuitivement mais subjectifs en même temps, car ils reposent sur un jugement humain informel pour accepter ou rejeter l’hypothèse nulle.

- Diagramme Q–Q , également appelé diagramme de probabilité normale ou diagramme de classement , est un diagramme des valeurs triées de l’ensemble de données par rapport aux valeurs attendues des quantiles correspondants de la distribution normale standard. C’est-à-dire qu’il s’agit d’un tracé de points de la forme (Φ −1 ( p k ), x ( k ) ), où les points de traçage p k sont égaux à p k = ( k − α )/( n + 1 − 2 α ) et αest une constante d’ajustement, qui peut être comprise entre 0 et 1. Si l’hypothèse nulle est vraie, les points tracés doivent se trouver approximativement sur une ligne droite.

- Graphique P – P – similaire au graphique Q – Q, mais utilisé beaucoup moins fréquemment. Cette méthode consiste à tracer les points (Φ( z ( k ) ), p k ), où z ( k ) = ( x ( k ) − μ ^ ) / σ ^ {displaystyle textstyle z_{(k)}=(x_{(k)}-{hat {mu }})/{hat {sigma }}}

. Pour des données normalement distribuées, ce tracé doit se trouver sur une ligne à 45° entre (0, 0) et (1, 1).

Tests d’adéquation :

Tests basés sur les moments :

- Test du K au carré de D’Agostino

- Essai de Jarque-Bera

- Test de Shapiro-Wilk : Ceci est basé sur le fait que la ligne dans le graphique Q–Q a la pente de σ . Le test compare l’estimation des moindres carrés de cette pente avec la valeur de la variance de l’échantillon et rejette l’hypothèse nulle si ces deux quantités diffèrent de manière significative.

Tests basés sur la fonction de distribution empirique :

- Test d’Anderson-Darling

- Test de Lilliefors (une adaptation du test de Kolmogorov-Smirnov )

Analyse bayésienne de la distribution normale

L’analyse bayésienne de données normalement distribuées est compliquée par les nombreuses possibilités différentes qui peuvent être envisagées :

- Soit la moyenne, soit la variance, soit ni l’une ni l’autre, peut être considérée comme une quantité fixe.

- Lorsque la variance est inconnue, l’analyse peut être effectuée directement en termes de variance, ou en termes de précision , l’inverse de la variance. La raison d’exprimer les formules en termes de précision est que l’analyse de la plupart des cas est simplifiée.

- Les cas univariés et multivariés doivent être pris en compte.

- Des distributions a priori conjuguées ou impropres peuvent être placées sur les variables inconnues.

- Un ensemble supplémentaire de cas se produit dans la régression linéaire bayésienne , où, dans le modèle de base, les données sont supposées être normalement distribuées et des priors normaux sont placés sur les coefficients de régression . L’analyse qui en résulte est similaire aux cas de base de données indépendantes identiquement distribuées .

Les formules pour les cas de régression non linéaire sont résumées dans l’ article antérieur conjugué .

Somme de deux quadratiques Forme scalaire

La formule auxiliaire suivante est utile pour simplifier les équations de mise à jour postérieure , qui autrement deviennent assez fastidieuses.

a ( x − y ) 2 + b ( x − z ) 2 = ( a + b ) ( x − a y + b z a + b ) 2 + a b a + b ( y − z ) 2 {displaystyle a(xy)^{2}+b(xz)^{2}=(a+b)left(x-{frac {ay+bz}{a+b}}right)^{ 2}+{frac {ab}{a+b}}(yz)^{2}}

Cette équation réécrit la somme de deux quadratiques en x en développant les carrés, en regroupant les termes en x et en complétant le carré . Notez ce qui suit au sujet des facteurs constants complexes attachés à certains des termes :

- Le facteur a y + b z a + b {displaystyle {frac {ay+bz}{a+b}}}

a la forme d’une moyenne pondérée de y et z .

- a b a + b = 1 1 a + 1 b = ( a − 1 + b − 1 ) − 1 . {displaystyle {frac {ab}{a+b}}={frac {1}{{frac {1}{a}}+{frac {1}{b}}}}=(a^ {-1}+b^{-1})^{-1}.}

Cela montre que ce facteur peut être considéré comme résultant d’une situation où les inverses des quantités a et b s’additionnent directement, donc pour combiner a et b eux-mêmes, il est nécessaire d’échanger, d’ajouter et d’échanger à nouveau le résultat pour revenir dans le unités d’origine. C’est exactement le genre d’opération effectuée par la moyenne harmonique , il n’est donc pas surprenant que a b a + b {displaystyle {frac {ab}{a+b}}}

est la moitié de la moyenne harmonique de a et b .

Forme vectorielle

Une formule similaire peut être écrite pour la somme de deux vecteurs quadratiques : Si x , y , z sont des vecteurs de longueur k , et A et B sont des matrices symétriques et inversibles de taille k × k {displaystyle kfois k}

, alors

( y − x ) ′ A ( y − x ) + ( x − z ) ′ B ( x − z ) = ( x − c ) ′ ( A + B ) ( x − c ) + ( y − z ) ′ ( A − 1 + B − 1 ) − 1 ( y − z ) {displaystyle {begin{aligned}&(mathbf {y} -mathbf {x} )’mathbf {A} (mathbf {y} -mathbf {x} )+(mathbf {x} – mathbf {z} )’mathbf {B} (mathbf {x} -mathbf {z} )\={}&(mathbf {x} -mathbf {c} )'(mathbf {A } +mathbf {B} )(mathbf {x} -mathbf {c} )+(mathbf {y} -mathbf {z} )'(mathbf {A} ^{-1}+mathbf {B} ^{-1})^{-1}(mathbf {y} -mathbf {z} )end{aligné}}}

où

c = ( A + B ) − 1 ( A y + B z ) {displaystyle mathbf {c} =(mathbf {A} +mathbf {B} )^{-1}(mathbf {A} mathbf {y} +mathbf {B} mathbf {z}) }

Notez que la forme x ′ A x est appelée une forme quadratique et est un scalaire :

x ′ A x = ∑ i , j a i j x i x j {displaystyle mathbf {x} ‘mathbf {A} mathbf {x} =sum _{i,j}a_{ij}x_{i}x_{j}}

En d’autres termes, il résume toutes les combinaisons possibles de produits de paires d’éléments de x , avec un coefficient séparé pour chacun. De plus, depuis x i x j = x j x i {displaystyle x_{i}x_{j}=x_{j}x_{i}}

, seule la somme a i j + a j i {displaystyle a_{ij}+a_{ji}}