Valeurs propres et vecteurs propres

En algèbre linéaire , un vecteur propre ( / ˈ aɪ ɡ ə n ˌ v ɛ k t ər / ) ou vecteur caractéristique d’une transformation linéaire est un vecteur différent de zéro qui change au plus d’un facteur scalaire lorsque cette transformation linéaire lui est appliquée. La valeur propre correspondante , souvent désignée par λ {displaystylelambda}

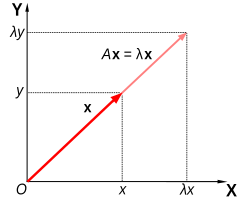

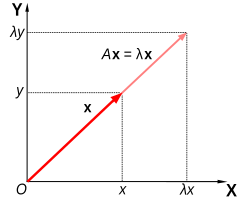

Géométriquement , un vecteur propre, correspondant à une valeur propre réelle non nulle, pointe dans une direction dans laquelle il est étiré par la transformation et la valeur propre est le facteur par lequel il est étiré. Si la valeur propre est négative, le sens est inversé. [1] En gros, dans un espace vectoriel multidimensionnel , le vecteur propre n’est pas tourné.

Définition formelle

Si T est une transformation linéaire d’un espace vectoriel V sur un corps F en lui-même et v est un vecteur non nul dans V , alors v est un vecteur propre de T si T ( v ) est un multiple scalaire de v . Ceci peut être écrit comme

T ( v ) = λ v , {displaystyle T(mathbf {v} )=lambda mathbf {v} ,}

où λ est un scalaire dans F , appelé valeur propre , valeur caractéristique ou racine caractéristique associée à v .

Il existe une correspondance directe entre les matrices carrées n sur n et les transformations linéaires d’un espace vectoriel à n dimensions en lui-même, quelle que soit la base de l’espace vectoriel. Ainsi, dans un espace vectoriel de dimension finie, il est équivalent de définir des valeurs propres et des vecteurs propres en utilisant soit le langage des matrices , soit le langage des transformations linéaires. [2] [3]

Si V est de dimension finie, l’équation ci-dessus est équivalente à [4]

A u = λ u . {displaystyle Amathbf {u} =lambda mathbf {u} .}

où A est la représentation matricielle de T et u est le vecteur de coordonnées de v .

Aperçu

Les valeurs propres et les vecteurs propres figurent en bonne place dans l’analyse des transformations linéaires. Le préfixe eigen- est adopté du mot allemand eigen ( apparenté au mot anglais propre ) pour “propre”, “caractéristique”, “propre”. [5] [6] Utilisés à l’origine pour étudier les axes principaux du mouvement de rotation des corps rigides , les valeurs propres et les vecteurs propres ont un large éventail d’applications, par exemple dans l’analyse de la stabilité , l’analyse des vibrations , les orbitales atomiques , la reconnaissance faciale etdiagonalisation matricielle .

En substance, un vecteur propre v d’une transformation linéaire T est un vecteur non nul qui, lorsque T lui est appliqué, ne change pas de direction. L’application de T au vecteur propre ne fait que mettre à l’échelle le vecteur propre par la valeur scalaire λ , appelée valeur propre. Cette condition peut s’écrire sous la forme de l’équation

T ( v ) = λ v , {displaystyle T(mathbf {v} )=lambda mathbf {v} ,}

appelée équation aux valeurs propres ou équation propre . En général, λ peut être n’importe quel scalaire . Par exemple, λ peut être négatif, auquel cas le vecteur propre inverse la direction dans le cadre de la mise à l’échelle, ou il peut être nul ou complexe .

Dans cette cartographie de cisaillement, la flèche rouge change de direction, mais pas la flèche bleue. La flèche bleue est un vecteur propre de cette cartographie de cisaillement car elle ne change pas de direction, et puisque sa longueur est inchangée, sa valeur propre est 1.

Dans cette cartographie de cisaillement, la flèche rouge change de direction, mais pas la flèche bleue. La flèche bleue est un vecteur propre de cette cartographie de cisaillement car elle ne change pas de direction, et puisque sa longueur est inchangée, sa valeur propre est 1.

Une matrice 2×2 réelle et symétrique représentant un étirement et un cisaillement du plan. Les vecteurs propres de la matrice (lignes rouges) sont les deux directions spéciales telles que chaque point sur eux glissera simplement dessus.

Une matrice 2×2 réelle et symétrique représentant un étirement et un cisaillement du plan. Les vecteurs propres de la matrice (lignes rouges) sont les deux directions spéciales telles que chaque point sur eux glissera simplement dessus.

L’ exemple de Mona Lisa illustré ici fournit une illustration simple. Chaque point du tableau peut être représenté par un vecteur pointant du centre du tableau vers ce point. La transformation linéaire dans cet exemple est appelée une cartographie de cisaillement . Les points de la moitié supérieure sont déplacés vers la droite et les points de la moitié inférieure sont déplacés vers la gauche, proportionnellement à leur distance par rapport à l’axe horizontal qui passe par le milieu du tableau. Les vecteurs pointant vers chaque point de l’image d’origine sont donc inclinés à droite ou à gauche, et rallongés ou raccourcis par la transformation. Points le longl’axe horizontal ne bouge pas du tout lorsque cette transformation est appliquée. Par conséquent, tout vecteur qui pointe directement vers la droite ou la gauche sans composante verticale est un vecteur propre de cette transformation, car le mappage ne change pas de direction. De plus, ces vecteurs propres ont tous une valeur propre égale à un, car la cartographie ne change pas non plus leur longueur.

Les transformations linéaires peuvent prendre de nombreuses formes différentes, mappant des vecteurs dans une variété d’espaces vectoriels, de sorte que les vecteurs propres peuvent également prendre de nombreuses formes. Par exemple, la transformation linéaire pourrait être un opérateur différentiel comme d d x {displaystyle {tfrac {d}{dx}}}

, auquel cas les vecteurs propres sont des fonctions appelées fonctions propres qui sont mises à l’échelle par cet opérateur différentiel, comme

d d x e λ x = λ e λ x . {displaystyle {frac {d}{dx}}e^{lambda x}=lambda e^{lambda x}.}

Alternativement, la transformation linéaire pourrait prendre la forme d’une matrice n par n , auquel cas les vecteurs propres sont des matrices n par 1. Si la transformation linéaire est exprimée sous la forme d’une matrice n par n A , alors l’équation aux valeurs propres pour une transformation linéaire ci-dessus peut être réécrite comme la multiplication matricielle

A v = λ v , {displaystyle Amathbf {v} =lambda mathbf {v} ,}

où le vecteur propre v est une matrice n par 1. Pour une matrice, les valeurs propres et les vecteurs propres peuvent être utilisés pour décomposer la matrice, par exemple en la diagonalisant .

Les valeurs propres et les vecteurs propres donnent lieu à de nombreux concepts mathématiques étroitement liés, et le préfixe eigen- est appliqué généreusement pour les nommer:

- L’ensemble de tous les vecteurs propres d’une transformation linéaire, chacun associé à sa valeur propre correspondante, est appelé le système propre de cette transformation. [7] [8]

- L’ensemble de tous les vecteurs propres de T correspondant à la même valeur propre, ainsi que le Vecteur zéro, est appelé un espace propre , ou l’ espace caractéristique de T associé à cette valeur propre. [9]

- Si un ensemble de vecteurs propres de T forme une base du domaine de T , alors cette base est appelée une base propre .

Histoire

Les valeurs propres sont souvent introduites dans le contexte de l’algèbre linéaire ou de la théorie des matrices . Historiquement, cependant, ils sont apparus dans l’étude des formes quadratiques et des équations différentielles .

Au XVIIIe siècle, Leonhard Euler étudie le mouvement de rotation d’un corps rigide et découvre l’importance des axes principaux . [a] Joseph-Louis Lagrange s’est rendu compte que les axes principaux sont les vecteurs propres de la matrice d’inertie. [dix]

Au début du XIXe siècle, Augustin-Louis Cauchy a vu comment leur travail pouvait être utilisé pour classer les surfaces quadriques et l’a généralisé à des dimensions arbitraires. [11] Cauchy a également inventé le terme racine caractéristique (racine caractéristique), pour ce qu’on appelle maintenant la valeur propre ; son terme survit dans l’ équation caractéristique . [c]

Plus tard, Joseph Fourier a utilisé les travaux de Lagrange et Pierre-Simon Laplace pour résoudre l’ équation de la chaleur par séparation de variables dans son célèbre livre de 1822 Théorie analytique de la chaleur . [12] Charles-François Sturm a développé les idées de Fourier plus loin et les a portées à l’attention de Cauchy, qui les a combinées avec ses propres idées et est arrivée au fait que les vraies matrices symétriques ont de vraies valeurs propres. [11] Cela a été étendu par Charles Hermite en 1855 à ce qu’on appelle maintenant les matrices hermitiennes . [13]

À peu près à la même époque, Francesco Brioschi a prouvé que les valeurs propres des matrices orthogonales se situent sur le cercle unitaire , [11] et Alfred Clebsch a trouvé le résultat correspondant pour les matrices asymétriques . [13] Enfin, Karl Weierstrass a clarifié un aspect important de la théorie de la stabilité initiée par Laplace, en réalisant que des matrices défectueuses peuvent provoquer une instabilité. [11]

Entre-temps, Joseph Liouville a étudié des problèmes aux valeurs propres similaires à ceux de Sturm ; la discipline qui est née de leur travail s’appelle maintenant la théorie de Sturm-Liouville . [14] Schwarz a étudié la première valeur propre de l’équation de Laplace sur des domaines généraux vers la fin du XIXe siècle, tandis que Poincaré a étudié l’équation de Poisson quelques années plus tard. [15]

Au début du XXe siècle, David Hilbert a étudié les valeurs propres des opérateurs intégraux en considérant les opérateurs comme des matrices infinies. [16] Il a été le premier à utiliser le mot allemand eigen , qui signifie “propre”, [6] pour désigner les valeurs propres et les vecteurs propres en 1904, [c] bien qu’il ait pu suivre un usage connexe par Hermann von Helmholtz . Pendant un certain temps, le terme standard en anglais était “valeur propre”, mais le terme plus distinctif “valeur propre” est la norme aujourd’hui. [17]

Le premier algorithme numérique de calcul des valeurs propres et des vecteurs propres est apparu en 1929, lorsque Richard von Mises a publié la méthode de la puissance . L’une des méthodes les plus populaires aujourd’hui, l’ algorithme QR , a été proposée indépendamment par John GF Francis [18] et Vera Kublanovskaya [19] en 1961. [20] [21]

Valeurs propres et vecteurs propres des matrices

Les valeurs propres et les vecteurs propres sont souvent présentés aux étudiants dans le cadre de cours d’algèbre linéaire axés sur les matrices. [22] [23] En outre, les transformations linéaires sur un espace vectoriel de dimension finie peuvent être représentées en utilisant des matrices, [2] [3] ce qui est particulièrement courant dans les applications numériques et informatiques. [24]

La matrice A agit en étirant le vecteur x , sans changer sa direction, donc x est un vecteur propre de A .

La matrice A agit en étirant le vecteur x , sans changer sa direction, donc x est un vecteur propre de A .

Considérez des vecteurs à n dimensions qui sont formés comme une liste de n scalaires, tels que les vecteurs à trois dimensions

x = [ 1 − 3 4 ] and y = [ − 20 60 − 80 ] . {displaystyle mathbf {x} ={begin{bmatrix}1\-3\4end{bmatrix}}quad {mbox{and}}quad mathbf {y} ={begin{ bmatrice}-20\60\-80end{bmatrice}}.}

Ces vecteurs sont dits multiples scalaires les uns des autres, ou parallèles ou colinéaires , s’il existe un scalaire λ tel que

x = λ y . {displaystyle mathbf {x} =lambda mathbf {y} .}

Dans ce cas λ = − 1 20 {displaystyle lambda =-{frac {1}{20}}}

.

Considérons maintenant la transformation linéaire de vecteurs à n dimensions définis par une matrice n par n A ,

A v = w , {displaystyle Amathbf {v} =mathbf {w} ,}

ou alors

[ A 11 A 12 ⋯ A 1 n A 21 A 22 ⋯ A 2 n ⋮ ⋮ ⋱ ⋮ A n 1 A n 2 ⋯ A n n ] [ v 1 v 2 ⋮ v n ] = [ w 1 w 2 ⋮ w n ] {displaystyle {begin{bmatrix}A_{11}&A_{12}&cdots &A_{1n}\A_{21}&A_{22}&cdots &A_{2n}\vdots &vdots & ddots &vdots \A_{n1}&A_{n2}&cdots &A_{nn}\end{bmatrix}}{begin{bmatrix}v_{1}\v_{2}\vdots v_{n}end{bmatrix}}={begin{bmatrix}w_{1}\w_{2}\vdots \w_{n}end{bmatrix}}}

où, pour chaque ligne,

w i = A i 1 v 1 + A i 2 v 2 + ⋯ + A i n v n = ∑ j = 1 n A i j v j . {displaystyle w_{i}=A_{i1}v_{1}+A_{i2}v_{2}+cdots +A_{in}v_{n}=sum _{j=1}^{n} A_{ij}v_{j}.}

S’il arrive que v et w soient des multiples scalaires, c’est-à-dire si

A v = w = λ v , {displaystyle Amathbf {v} =mathbf {w} =lambda mathbf {v} ,}  |

( 1 ) |

alors v est un vecteur propre de la transformation linéaire A et le facteur d’échelle λ est la valeur propre correspondant à ce vecteur propre. L’ équation ( 1 ) est l’ équation aux valeurs propres de la matrice A.

L’équation ( 1 ) peut être énoncée de manière équivalente comme

( A − λ I ) v = 0 , {displaystyle left(A-lambda Iright)mathbf {v} =mathbf {0} ,}  |

( 2 ) |

où I est la matrice d’identité n par n et 0 est le Vecteur zéro.

Valeurs propres et polynôme caractéristique

L’équation ( 2 ) admet une solution v non nulle si et seulement si le déterminant de la matrice ( A − λI ) est nul. Par conséquent, les valeurs propres de A sont des valeurs de λ qui satisfont l’équation

| A − λ I | = 0 {displaystyle |A-lambda I|=0}  |

( 3 ) |

En utilisant la règle de Leibniz pour le déterminant, le côté gauche de l’équation ( 3 ) est une fonction polynomiale de la variable λ et le degré de ce polynôme est n , l’ordre de la matrice A . Ses coefficients dépendent des entrées de A , sauf que son terme de degré n est toujours (−1) n λ n . Ce polynôme est appelé le polynôme caractéristique de A . L’ équation ( 3 ) est appelée équation caractéristique ouÉquation séculaire de A .

Le théorème fondamental de l’algèbre implique que le polynôme caractéristique d’une matrice n -par- n A , étant un polynôme de degré n , peut être factorisé dans le produit de n termes linéaires,

| A − λ I | = ( λ 1 − λ ) ( λ 2 − λ ) ⋯ ( λ n − λ ) , {displaystyle |A-lambda I|=(lambda _{1}-lambda )(lambda _{2}-lambda )cdots (lambda _{n}-lambda ),}  |

( 4 ) |

où chaque λ i peut être réel mais est en général un nombre complexe. Les nombres λ 1 , λ 2 , …, λ n , qui peuvent ne pas tous avoir des valeurs distinctes, sont racines du polynôme et sont les valeurs propres de A .

Comme bref exemple, qui est décrit plus en détail dans la section des exemples plus loin, considérons la matrice

A = [ 2 1 1 2 ] . {displaystyle A={begin{bmatrix}2&1\1&2end{bmatrix}}.}

En prenant le déterminant de ( A − λI ) , le polynôme caractéristique de A est

| A − λ I | = | 2 − λ 1 1 2 − λ | = 3 − 4 λ + λ 2 . {displaystyle |A-lambda I|={begin{vmatrix}2-lambda &1\1&2-lambda end{vmatrix}}=3-4lambda +lambda ^{2}.}

En fixant le polynôme caractéristique égal à zéro, il a pour racines λ=1 et λ=3 , qui sont les deux valeurs propres de A . Les vecteurs propres correspondant à chaque valeur propre peuvent être trouvés en résolvant les composantes de v dans l’équation ( A − λ I ) v = 0 {displaystyle left(A-lambda Iright)mathbf {v} =mathbf {0} }

v λ = 1 = [ 1 − 1 ] , v λ = 3 = [ 1 1 ] . {displaystyle mathbf {v} _{lambda =1}={begin{bmatrix}1\-1end{bmatrix}},quad mathbf {v} _{lambda =3}={ begin{bmatrice}1\1end{bmatrice}}.}

Si les entrées de la matrice A sont toutes des nombres réels, alors les coefficients du polynôme caractéristique seront également des nombres réels, mais les valeurs propres peuvent toujours avoir des parties imaginaires non nulles. Les entrées des vecteurs propres correspondants peuvent donc également avoir des parties imaginaires non nulles. De même, les valeurs propres peuvent être des nombres irrationnels même si toutes les entrées de A sont des nombres rationnels ou même si elles sont toutes des nombres entiers. Cependant, si les entrées de A sont toutes des nombres algébriques , qui incluent les rationnels, les valeurs propres sont des nombres algébriques complexes.

Les racines non réelles d’un polynôme réel à coefficients réels peuvent être regroupées en paires de conjugués complexes , c’est-à-dire avec les deux membres de chaque paire ayant des parties imaginaires qui ne diffèrent que par le signe et la même partie réelle. Si le degré est impair, alors par le théorème des valeurs intermédiaires au moins une des racines est réelle. Par conséquent, toute Matrice réelle d’ordre impair a au moins une valeur propre réelle, alors qu’une Matrice réelle d’ordre pair peut ne pas avoir de valeurs propres réelles. Les vecteurs propres associés à ces valeurs propres complexes sont également complexes et apparaissent également dans des paires conjuguées complexes.

Multiplicité algébrique

Soit λ i une valeur propre d’une matrice n par n A . La multiplicité algébrique μ A ( λ i ) de la valeur propre est sa multiplicité en tant que racine du polynôme caractéristique, c’est-à-dire le plus grand entier k tel que ( λ − λ i ) k divise uniformément ce polynôme. [9] [25] [26]

Supposons qu’une matrice A ait une dimension n et d ≤ n valeurs propres distinctes. Alors que l’équation ( 4 ) factorise le polynôme caractéristique de A dans le produit de n termes linéaires avec certains termes potentiellement répétitifs, le polynôme caractéristique peut plutôt être écrit comme le produit de d termes correspondant chacun à une valeur propre distincte et élevé à la puissance de la multiplicité algébrique,

| A − λ I | = ( λ 1 − λ ) μ A ( λ 1 ) ( λ 2 − λ ) μ A ( λ 2 ) ⋯ ( λ d − λ ) μ A ( λ d ) . {displaystyle |A-lambda I|=(lambda _{1}-lambda )^{mu _{A}(lambda _{1})}(lambda _{2}-lambda) ^{mu _{A}(lambda _{2})}cdots (lambda _{d}-lambda )^{mu _{A}(lambda _{d})}.}

Si d = n alors le membre de droite est le produit de n termes linéaires et c’est la même chose que l’équation ( 4 ). La taille de la multiplicité algébrique de chaque valeur propre est liée à la dimension n comme

1 ≤ μ A ( λ i ) ≤ n , μ A = ∑ i = 1 d μ A ( λ i ) = n . {displaystyle {begin{aligned}1&leq mu _{A}(lambda _{i})leq n,\mu _{A}&=sum _{i=1}^{ d}mu _{A}left(lambda _{i}right)=n.end{aligned}}}

Si μ A ( λ i ) = 1, on dit que λ i est une valeur propre simple . [26] Si μ A ( λ i ) est égal à la multiplicité géométrique de λ i , γ A ( λ i ), définie dans la section suivante, on dit que λ i est une valeur propre semi -simple .

Espaces propres, multiplicité géométrique et base propre des matrices

Étant donné une valeur propre particulière λ de la matrice n par n A , définissez l’ ensemble E comme étant tous les vecteurs v qui satisfont l’équation ( 2 ),

E = { v : ( A − λ I ) v = 0 } . {displaystyle E=left{mathbf {v} :left(A-lambda Iright)mathbf {v} =mathbf {0} right}.}

D’une part, cet ensemble est précisément le noyau ou espace nul de la matrice ( A − λI ). Par contre, par définition, tout vecteur non nul qui satisfait à cette condition est un vecteur propre de A associé à λ . Ainsi, l’ensemble E est l’ union du Vecteur zéro avec l’ensemble de tous les vecteurs propres de A associés à λ , et E est égal à l’espace nul de ( A − λI ). E est appelé espace propre ou espace caractéristique de A associé àλ . [27] [9] En général λ est un nombre complexe et les vecteurs propres sont complexes n par 1 matrices. Une propriété de l’espace nul est qu’il s’agit d’un sous- espace linéaire , donc E est un sous-espace linéaire de C n .

Parce que l’espace propre E est un sous-espace linéaire, il est fermé par addition. Autrement dit, si deux vecteurs u et v appartiennent à l’ensemble E , noté u , v ∈ E , alors ( u + v ) ∈ E ou de manière équivalente A ( u + v ) = λ ( u + v ) . Ceci peut être vérifié en utilisant la propriété distributive de la multiplication matricielle. De même, parce que Eest un sous-espace linéaire, il est fermé par multiplication scalaire. Autrement dit, si v ∈ E et α est un nombre complexe, ( α v ) ∈ E ou de manière équivalente A ( α v ) = λ ( α v ) . Ceci peut être vérifié en notant que la multiplication de matrices complexes par des nombres complexes est commutative . Tant que u + v et α v ne sont pas nuls, ce sont aussi des vecteurs propres de A associés à λ .

La dimension de l’espace propre E associé à λ , ou de manière équivalente le nombre maximal de vecteurs propres linéairement indépendants associés à λ , est appelée multiplicité géométrique de la valeur propre γ A ( λ ). Comme E est aussi l’espace nul de ( A − λI ), la multiplicité géométrique de λ est la dimension de l’espace nul de ( A − λI ), aussi appelée nullité de ( A − λI ), qui se rapporte à la dimension et au rang de ( UNE –λI ) comme

γ A ( λ ) = n − rank ( A − λ I ) . {displaystyle gamma _{A}(lambda )=n-operatorname {rang} (A-lambda I).}

En raison de la définition des valeurs propres et des vecteurs propres, la multiplicité géométrique d’une valeur propre doit être d’au moins un, c’est-à-dire que chaque valeur propre a au moins un vecteur propre associé. De plus, la multiplicité géométrique d’une valeur propre ne peut excéder sa multiplicité algébrique. De plus, rappelez-vous que la multiplicité algébrique d’une valeur propre ne peut pas dépasser n .

1 ≤ γ A ( λ ) ≤ μ A ( λ ) ≤ n {displaystyle 1leq gamma _{A}(lambda )leq mu _{A}(lambda )leq n}

Pour prouver l’inégalité γ A ( λ ) ≤ μ A ( λ ) {displaystyle gamma _{A}(lambda )leq mu _{A}(lambda )}

, considérons comment la définition de la multiplicité géométrique implique l’existence de γ A ( λ ) {displaystyle gamma _{A}(lambda)}

vecteurs propres orthonormés v 1 , … , v γ A ( λ ) {displaystyle {boldsymbol {v}}_{1},,ldots ,,{boldsymbol {v}}_{gamma _{A}(lambda)}}

, tel que A v k = λ v k {displaystyle A{boldsymbol {v}}_{k}=lambda {boldsymbol {v}}_{k}}

. On peut donc trouver une matrice (unitaire) V {style d’affichage V}

dont le premier γ A ( λ ) {displaystyle gamma _{A}(lambda)}

les colonnes sont ces vecteurs propres, et dont les colonnes restantes peuvent être n’importe quel ensemble orthonormé de n − γ A ( λ ) {displaystyle n-gamma _{A}(lambda )}

vecteurs orthogonaux à ces vecteurs propres de A {displaystyle A}

. Puis V {style d’affichage V}

a un rang plein et est donc inversible, et A V = V D {displaystyle AV=VD}

avec D {displaystyle D}

une matrice dont le bloc supérieur gauche est la matrice diagonale λ I γ A ( λ ) {displaystyle lambda I_{gamma _{A}(lambda )}}

. Cela implique que ( A − ξ I ) V = V ( D − ξ I ) {displaystyle (A-xi I)V=V(D-xi I)}

. En d’autres termes, A − ξ I {displaystyle A-xi I}

est similaire à D − ξ I {displaystyle D-xi I}

, ce qui implique que det ( A − ξ I ) = det ( D − ξ I ) {displaystyle det(A-xi I)=det(D-xi I)}

. Mais d’après la définition de D {displaystyle D}

nous savons que det ( D − ξ I ) {displaystyle det(D-xi I)}

contient un facteur ( ξ − λ ) γ A ( λ ) {displaystyle (xi -lambda )^{gamma _{A}(lambda )}}

, ce qui signifie que la multiplicité algébrique de λ {displaystylelambda}

doit satisfaire μ A ( λ ) ≥ γ A ( λ ) {displaystyle mu _{A}(lambda )geq gamma _{A}(lambda )}

.

Supposer A {displaystyle A}

possède d ≤ n {displaystyle dleq n}

valeurs propres distinctes λ 1 , … , λ d {displaystyle lambda _{1},ldots ,lambda _{d}}

, où la multiplicité géométrique de λ i {displaystyle lambda _{i}}

est γ A ( λ i ) {displaystyle gamma _{A}(lambda _{i})}

. La multiplicité géométrique totale de A {displaystyle A}

,

γ A = ∑ i = 1 d γ A ( λ i ) , d ≤ γ A ≤ n , {displaystyle {begin{aligned}gamma _{A}&=sum _{i=1}^{d}gamma _{A}(lambda _{i}),\d&leq gamma _{A}leq n,end{aligné}}}

est la dimension de la somme de tous les espaces propres de A {displaystyle A}

les valeurs propres de , ou de manière équivalente le nombre maximal de vecteurs propres linéairement indépendants de A {displaystyle A}

. Si γ A = n {displaystyle gamma _{A}=n}

- La somme directe des espaces propres de tous A {displaystyle A}

les valeurs propres de sont l’ensemble de l’espace vectoriel C n {displaystyle mathbb{C} ^{n}}

.

- Une base de C n {displaystyle mathbb{C} ^{n}}

peut être formé à partir n {displaystyle n}

vecteurs propres linéairement indépendants de A {displaystyle A}

; une telle base s’appelle une base propre

- Tout vecteur dans C n {displaystyle mathbb{C} ^{n}}

peut être écrit comme une combinaison linéaire de vecteurs propres de A {displaystyle A}

.

Propriétés supplémentaires des valeurs propres

Laisser A {displaystyle A}

être un arbitraire n × n {displaystyle nfois n}

matrice de nombres complexes à valeurs propres λ 1 , … , λ n {displaystyle lambda _{1},ldots ,lambda _{n}}

. Chaque valeur propre apparaît μ A ( λ i ) {displaystyle mu _{A}(lambda _{i})}

fois dans cette liste, où μ A ( λ i ) {displaystyle mu _{A}(lambda _{i})}

est la multiplicité algébrique de la valeur propre. Voici les propriétés de cette matrice et ses valeurs propres :

- La trace de A {displaystyle A}

, défini comme la somme de ses éléments diagonaux, est aussi la somme de toutes les valeurs propres, [28] [29] [30] tr ( A ) = ∑ i = 1 n a i i = ∑ i = 1 n λ i = λ 1 + λ 2 + ⋯ + λ n . {displaystyle operatorname {tr} (A)=sum _{i=1}^{n}a_{ii}=sum _{i=1}^{n}lambda _{i}=lambda _{1}+lambda _{2}+cdots +lambda _{n}.}

- Le déterminant de A {displaystyle A}

est le produit de toutes ses valeurs propres, [28] [31] [32] det ( A ) = ∏ i = 1 n λ i = λ 1 λ 2 ⋯ λ n . {displaystyle det(A)=prod _{i=1}^{n}lambda _{i}=lambda _{1}lambda _{2}cdots lambda _{n}.}

- Les valeurs propres des k {displaystyle k}

ème puissance de A {displaystyle A}

; c’est-à-dire les valeurs propres de A k {displaystyle A^{k}}

, pour tout entier positif k {displaystyle k}

, sont λ 1 k , … , λ n k {displaystyle lambda _{1}^{k},ldots ,lambda _{n}^{k}}

.

- La matrice A {displaystyle A}

est inversible si et seulement si chaque valeur propre est non nulle.

- Si A {displaystyle A}

est inversible, alors les valeurs propres de A − 1 {displaystyle A^{-1}}

sont 1 λ 1 , … , 1 λ n {textstyle {frac {1}{lambda _{1}}},ldots ,{frac {1}{lambda _{n}}}}

et la multiplicité géométrique de chaque valeur propre coïncide. De plus, puisque le polynôme caractéristique de l’inverse est le polynôme réciproque de l’original, les valeurs propres partagent la même multiplicité algébrique.

- Si A {displaystyle A}

est égal à sa transposée conjuguée A ∗ {displaystyle A^{*}}

, ou de manière équivalente si A {displaystyle A}

est hermitienne , alors toute valeur propre est réelle. Il en va de même pour toute Matrice réelle symétrique .

- Si A {displaystyle A}

n’est pas seulement hermitienne mais aussi positive-définie , positive-semi-définie, négative-définie ou négative-semi-définie, alors chaque valeur propre est respectivement positive, non négative, négative ou non positive.

- Si A {displaystyle A}

est unitaire , chaque valeur propre a une valeur absolue | λ i | = 1 {displaystyle |lambda _{i}|=1}

.

- si A {displaystyle A}

est un n × n {displaystyle nfois n}

matrice et { λ 1 , … , λ k } {displaystyle {lambda _{1},ldots ,lambda _{k}}}

sont ses valeurs propres, alors les valeurs propres de matrice I + A {displaystyle I+A}

(où I {displaystyle I}

est la matrice identité) sont { λ 1 + 1 , … , λ k + 1 } {displaystyle {lambda _{1}+1,ldots ,lambda _{k}+1}}

. De plus, si α ∈ C {displaystyle alpha in mathbb {C} }

, les valeurs propres de α I + A {displaystyle alpha I+A}

sont { λ 1 + α , … , λ k + α } {displaystyle {lambda _{1}+alpha ,ldots ,lambda _{k}+alpha }}

. Plus généralement, pour un polynôme P {displaystyle P}

les valeurs propres de matrice P ( A ) {displaystyle P(A)}

sont { P ( λ 1 ) , … , P ( λ k ) } {displaystyle {P(lambda _{1}),ldots ,P(lambda _{k})}}

.

vecteurs propres gauche et droite

De nombreuses disciplines représentent traditionnellement les vecteurs comme des matrices à une seule colonne plutôt que comme des matrices à une seule ligne. Pour cette raison, le mot “vecteur propre” dans le contexte des matrices fait presque toujours référence à un vecteur propre droit , à savoir un vecteur colonne qui multiplie à droite le n × n {displaystyle nfois n}

matrice A {displaystyle A}

dans l’équation de définition, l’équation ( 1 ),

A v = λ v . {displaystyle Amathbf {v} =lambda mathbf {v} .}

Le problème des valeurs propres et des vecteurs propres peut également être défini pour les vecteurs de ligne qui ont laissé la matrice de multiplication A {displaystyle A}

. Dans cette formulation, l’équation de définition est

u A = κ u , {displaystyle mathbf {u} A=kappa mathbf {u} ,}

où κ {displaystylekappa}

est un scalaire et u {displaystyle u}

est un 1 × n {displaystyle 1fois n}

matrice. Tout vecteur ligne u {displaystyle u}

satisfaisant cette équation est appelé un vecteur propre gauche de A {displaystyle A}

et κ {displaystylekappa}

est sa valeur propre associée. En prenant la transposée de cette équation,

A T u T = κ u T . {displaystyle A^{textsf {T}}mathbf {u} ^{textsf {T}}=kappa mathbf {u} ^{textsf {T}}.}

En comparant cette équation à l’équation ( 1 ), il s’ensuit immédiatement qu’un vecteur propre gauche de A {displaystyle A}

est identique à la transposée d’un vecteur propre à droite de A T {displaystyle A^{textsf {T}}}

, avec la même valeur propre. De plus, puisque le polynôme caractéristique de A T {displaystyle A^{textsf {T}}}

est le même que le polynôme caractéristique de A {displaystyle A}

, les valeurs propres des vecteurs propres gauches de A {displaystyle A}

sont les mêmes que les valeurs propres des vecteurs propres droits de A T {displaystyle A^{textsf {T}}}

.

Diagonalisation et décomposition propre

Supposons que les vecteurs propres de A forment une base, ou de manière équivalente A a n vecteurs propres linéairement indépendants v 1 , v 2 , …, v n avec des valeurs propres associées λ 1 , λ 2 , …, λ n . Les valeurs propres n’ont pas besoin d’être distinctes. Définissons une matrice carrée Q dont les colonnes sont les n vecteurs propres linéairement indépendants de A ,

Q = [ v 1 v 2 ⋯ v n ] . {displaystyle Q={begin{bmatrix}mathbf {v} _{1}&mathbf {v} _{2}&cdots &mathbf {v} _{n}end{bmatrix}}. }

Puisque chaque colonne de Q est un vecteur propre de A , la multiplication à droite de A par Q met à l’échelle chaque colonne de Q par sa valeur propre associée,

A Q = [ λ 1 v 1 λ 2 v 2 ⋯ λ n v n ] . {displaystyle AQ={begin{bmatrix}lambda _{1}mathbf {v} _{1}&lambda _{2}mathbf {v} _{2}&cdots &lambda _{ n}mathbf {v} _{n}end{bmatrice}}.}

Dans cet esprit, définissons une matrice diagonale Λ où chaque élément diagonal Λ ii est la valeur propre associée à la i ème colonne de Q . Puis

A Q = Q Λ . {displaystyle AQ=QLambda .}

Comme les colonnes de Q sont linéairement indépendantes, Q est inversible. Multipliant à droite les deux membres de l’équation par Q −1 ,

A = Q Λ Q − 1 , {displaystyle A=QLambda Q^{-1},}

ou en multipliant plutôt à gauche les deux côtés par Q −1 ,

Q − 1 A Q = Λ . {displaystyle Q^{-1}AQ=Lambda .}

A peut donc être décomposé en une matrice composée de ses vecteurs propres, une matrice diagonale avec ses valeurs propres le long de la diagonale, et l’inverse de la matrice des vecteurs propres. C’est ce qu’on appelle la décomposition propre et c’est une transformation de similarité . Une telle matrice A est dite semblable à la matrice diagonale Λ ou diagonalisable . La matrice Q est la matrice de changement de base de la transformation de similarité. Essentiellement, les matrices A et Λ représentent la même transformation linéaire exprimée dans deux bases différentes. Les vecteurs propres sont utilisés comme base lors de la représentation de la transformation linéaire en tant que Λ.

Inversement, supposons qu’une matrice A soit diagonalisable. Soit P une matrice carrée non singulière telle que P −1 AP est une matrice diagonale D . En multipliant à gauche les deux par P , AP = PD . Chaque colonne de P doit donc être un vecteur propre de A dont la valeur propre est l’élément diagonal correspondant de D . Puisque les colonnes de P doivent être linéairement indépendantes pour que P soit inversible, il existe n vecteurs propres linéairement indépendants de A . Il s’ensuit que les vecteurs propres deA forme une base si et seulement si A est diagonalisable.

Une matrice non diagonalisable est dite défectueuse . Pour les matrices défectueuses, la notion de vecteurs propres se généralise aux vecteurs propres généralisés et la matrice diagonale des valeurs propres se généralise à la forme normale de Jordan . Sur un corps algébriquement clos, toute matrice A a une forme normale de Jordan et admet donc une base de vecteurs propres généralisés et une décomposition en espaces propres généralisés .

Caractérisation variationnelle

Dans le cas hermitien , les valeurs propres peuvent recevoir une caractérisation variationnelle. La plus grande valeur propre de H {displaystyle H}

est la valeur maximale de la forme quadratique x T H x / x T x {displaystyle mathbf {x} ^{textsf {T}}Hmathbf {x} /mathbf {x} ^{textsf {T}}mathbf {x} }

. Une valeur de x {displaystyle mathbf {x} }

qui réalise ce maximum, est un vecteur propre.

Exemples de matrice

Exemple de matrice bidimensionnelle

La matrice de transformation A = [ 2 1 1 2 ] {displaystyle left[{begin{smallmatrix}2&1\1&2end{smallmatrix}}right]}

La matrice de transformation A = [ 2 1 1 2 ] {displaystyle left[{begin{smallmatrix}2&1\1&2end{smallmatrix}}right]} ![{displaystyle left[{begin{smallmatrix}2&1\1&2end{smallmatrix}}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/838a30dc9d065ec434dff490bd84061ed569db3b)

conserve la direction des vecteurs violets parallèles à v λ =1 = [1 −1] T et des vecteurs bleus parallèles à v λ =3 = [1 1] T . Les vecteurs rouges ne sont parallèles à aucun vecteur propre, donc leurs directions sont modifiées par la transformation. Les longueurs des vecteurs violets sont inchangées après la transformation (en raison de leur valeur propre de 1), tandis que les vecteurs bleus sont trois fois la longueur de l’original (en raison de leur valeur propre de 3). Voir aussi : Une version étendue, montrant les quatre quadrants .

Considérez la matrice

A = [ 2 1 1 2 ] . {displaystyle A={begin{bmatrix}2&1\1&2end{bmatrix}}.}

La figure de droite montre l’effet de cette transformation sur les coordonnées des points dans le plan. Les vecteurs propres v de cette transformation satisfont l’équation ( 1 ), et les valeurs de λ pour lesquelles le déterminant de la matrice ( A − λI ) vaut zéro sont les valeurs propres.

En prenant le déterminant pour trouver le polynôme caractéristique de A ,

| A − λ I | = | [ 2 1 1 2 ] − λ [ 1 0 0 1 ] | = | 2 − λ 1 1 2 − λ | = 3 − 4 λ + λ 2 = ( λ − 3 ) ( λ − 1 ) . {displaystyle {begin{aligned}|A-lambda I|&=left|{begin{bmatrix}2&1\1&2end{bmatrix}}-lambda {begin{bmatrix}1&0\0&1 end{bmatrix}}right|={begin{vmatrix}2-lambda &1\1&2-lambda end{vmatrix}}\[6pt]&=3-4lambda +lambda ^{ 2}\[6pt]&=(lambda -3)(lambda -1).end{aligné}}} ![{displaystyle {begin{aligned}|A-lambda I|&=left|{begin{bmatrix}2&1\1&2end{bmatrix}}-lambda {begin{bmatrix}1&0\0&1end{bmatrix}}right|={begin{vmatrix}2-lambda &1\1&2-lambda end{vmatrix}}\[6pt]&=3-4lambda +lambda ^{2}\[6pt]&=(lambda -3)(lambda -1).end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0084c80ab8c7637830cdf01f1c754f92a6598ac0)

En fixant le polynôme caractéristique égal à zéro, il a pour racines λ =1 et λ =3 , qui sont les deux valeurs propres de A .

Pour λ =1 , l’équation ( 2 ) devient,

( A − I ) v λ = 1 = [ 1 1 1 1 ] [ v 1 v 2 ] = [ 0 0 ] {displaystyle (AI)mathbf {v} _{lambda =1}={begin{bmatrix}1&1\1&1end{bmatrix}}{begin{bmatrix}v_{1}\v_{2 }end{bmatrix}}={begin{bmatrix}0\0end{bmatrix}}}

1 v 1 + 1 v 2 = 0 {displaystyle 1v_{1}+1v_{2}=0}

; 1 v 1 + 1 v 2 = 0 {displaystyle 1v_{1}+1v_{2}=0}

Tout vecteur non nul avec v 1 = − v 2 résout cette équation. Donc,

v λ = 1 = [ v 1 − v 1 ] = [ 1 − 1 ] {displaystyle mathbf {v} _{lambda =1}={begin{bmatrix}v_{1}\-v_{1}end{bmatrix}}={begin{bmatrix}1\- 1end{bmatrice}}}

est un vecteur propre de A correspondant à λ = 1, comme l’est tout multiple scalaire de ce vecteur.

Pour λ =3 , l’équation ( 2 ) devient

( A − 3 I ) v λ = 3 = [ − 1 1 1 − 1 ] [ v 1 v 2 ] = [ 0 0 ] − 1 v 1 + 1 v 2 = 0 ; 1 v 1 − 1 v 2 = 0 {displaystyle {begin{aligned}(A-3I)mathbf {v} _{lambda =3}&={begin{bmatrix}-1&1\1&-1end{bmatrix}}{begin {bmatrix}v_{1}\v_{2}end{bmatrix}}={begin{bmatrix}0\0end{bmatrix}}\-1v_{1}+1v_{2}&= 0;\1v_{1}-1v_{2}&=0end{aligné}}}

Tout vecteur non nul avec v 1 = v 2 résout cette équation. Donc,

v λ = 3 = [ v 1 v 1 ] = [ 1 1 ] {displaystyle mathbf {v} _{lambda =3}={begin{bmatrix}v_{1}\v_{1}end{bmatrix}}={begin{bmatrix}1\1 fin{bmatrice}}}

est un vecteur propre de A correspondant à λ = 3, comme l’est tout multiple scalaire de ce vecteur.

Ainsi, les vecteurs v λ =1 et v λ =3 sont des vecteurs propres de A associés respectivement aux valeurs propres λ =1 et λ =3 .

Formule générale des valeurs propres d’une matrice bidimensionnelle

Les valeurs propres de la Matrice réelle A = [ a b c d ] {displaystyle A={begin{bmatrix}a&b\c&dend{bmatrix}}}

sont [d]

λ = 1 2 ( a + d ) ± ( 1 2 ( a − d ) ) 2 + b c = 1 2 ( tr ( A ) ± ( tr ( A ) ) 2 − 4 det ( A ) ) . {displaystyle lambda ={frac {1}{2}}(a+d)pm {sqrt {left({frac {1}{2}}(ad)right)^{2} +bc}}={frac {1}{2}}left(operatorname {tr} (A)pm {sqrt {left(operatorname {tr} (A)right)^{2} -4det(A)}}right).}

Une autre représentation est : λ = 1 2 tr ( A ) ± ( 1 2 tr ( A ) ) 2 − det ( A ) . {displaystyle lambda ={frac {1}{2}}operatorname {tr} (A)pm {sqrt {left({frac {1}{2}}operatorname {tr} (A )right)^{2}-det(A)}}.}

Notez que les valeurs propres sont toujours réelles si b et c ont le même signe, car la quantité sous le radical doit être positive.

Exemple de matrice tridimensionnelle

Considérez la matrice

A = [ 2 0 0 0 3 4 0 4 9 ] . {displaystyle A={begin{bmatrix}2&0&0\0&3&4\0&4&9end{bmatrix}}.}

Le polynôme caractéristique de A est

| A − λ I | = | [ 2 0 0 0 3 4 0 4 9 ] − λ [ 1 0 0 0 1 0 0 0 1 ] | = | 2 − λ 0 0 0 3 − λ 4 0 4 9 − λ | , = ( 2 − λ ) [ ( 3 − λ ) ( 9 − λ ) − 16 ] = − λ 3 + 14 λ 2 − 35 λ + 22. {displaystyle {begin{aligned}|A-lambda I|&=left|{begin{bmatrix}2&0&0\0&3&4\0&4&9end{bmatrix}}-lambda {begin{bmatrix}1&0&0 \0&1&0\0&0&1end{bmatrix}}right|={begin{vmatrix}2-lambda &0&0\0&3-lambda &4\0&4&9-lambda end{vmatrix}},\[ 6pt]&=(2-lambda ){bigl [}(3-lambda )(9-lambda )-16{bigr ]}=-lambda ^{3}+14lambda ^{2} -35lambda +22.end{aligné}}} ![{displaystyle {begin{aligned}|A-lambda I|&=left|{begin{bmatrix}2&0&0\0&3&4\0&4&9end{bmatrix}}-lambda {begin{bmatrix}1&0&0\0&1&0\0&0&1end{bmatrix}}right|={begin{vmatrix}2-lambda &0&0\0&3-lambda &4\0&4&9-lambda end{vmatrix}},\[6pt]&=(2-lambda ){bigl [}(3-lambda )(9-lambda )-16{bigr ]}=-lambda ^{3}+14lambda ^{2}-35lambda +22.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/30165fb86a7e23644d2e3373a1c2c68af4756523)

Les racines du polynôme caractéristique sont 2, 1 et 11, qui sont les trois seules valeurs propres de A . Ces valeurs propres correspondent aux vecteurs propres [ 1 0 0 ] T {displaystyle {begin{bmatrix}1&0&0end{bmatrix}}^{textsf {T}}}

, [ 0 − 2 1 ] T {displaystyle {begin{bmatrix}0&-2&1end{bmatrix}}^{textsf {T}}}

, et [ 0 1 2 ] T {displaystyle {begin{bmatrix}0&1&2end{bmatrix}}^{textsf {T}}}

, ou tout multiple non nul de celui-ci.

Exemple de matrice tridimensionnelle avec des valeurs propres complexes

Considérons la matrice de permutation cyclique

A = [ 0 1 0 0 0 1 1 0 0 ] . {displaystyle A={begin{bmatrix}0&1&0\0&0&1\1&0&0end{bmatrix}}.}

Cette matrice décale les coordonnées du vecteur d’une position vers le haut et déplace la première coordonnée vers le bas. Son polynôme caractéristique est 1 − λ 3 , dont les racines sont

λ 1 = 1 λ 2 = − 1 2 + i 3 2 λ 3 = λ 2 ∗ = − 1 2 − i 3 2 {displaystyle {begin{aligned}lambda _{1}&=1\lambda _{2}&=-{frac {1}{2}}+i{frac {sqrt {3} }{2}}\lambda _{3}&=lambda _{2}^{*}=-{frac {1}{2}}-i{frac {sqrt {3}}{ 2}}end{aligné}}}

où i {displaystyle i}

est une unité imaginaire avec i 2 = − 1 {displaystyle i^{2}=-1}

.

Pour la valeur propre réelle λ 1 = 1, tout vecteur avec trois entrées égales non nulles est un vecteur propre. Par example,

A [ 5 5 5 ] = [ 5 5 5 ] = 1 ⋅ [ 5 5 5 ] . {displaystyle A{begin{bmatrix}5\5\5end{bmatrix}}={begin{bmatrix}5\5\5end{bmatrix}}=1cdot {begin {bmatrice}5\5\5end{bmatrice}}.}

Pour la paire conjuguée complexe de valeurs propres imaginaires,

λ 2 λ 3 = 1 , λ 2 2 = λ 3 , λ 3 2 = λ 2 . {displaystyle lambda _{2}lambda _{3}=1,quad lambda _{2}^{2}=lambda _{3},quad lambda _{3}^{2} =lambda _{2}.}

Puis

A [ 1 λ 2 λ 3 ] = [ λ 2 λ 3 1 ] = λ 2 ⋅ [ 1 λ 2 λ 3 ] , {displaystyle A{begin{bmatrix}1\lambda _{2}\lambda _{3}end{bmatrix}}={begin{bmatrix}lambda _{2}\lambda _{3}\1end{bmatrix}}=lambda _{2}cdot {begin{bmatrix}1\lambda _{2}\lambda _{3}end{bmatrix} },}

et

A [ 1 λ 3 λ 2 ] = [ λ 3 λ 2 1 ] = λ 3 ⋅ [ 1 λ 3 λ 2 ] . {displaystyle A{begin{bmatrix}1\lambda _{3}\lambda _{2}end{bmatrix}}={begin{bmatrix}lambda _{3}\lambda _{2}\1end{bmatrix}}=lambda _{3}cdot {begin{bmatrix}1\lambda _{3}\lambda _{2}end{bmatrix} }.}

Par conséquent, les deux autres vecteurs propres de A sont complexes et sont v λ 2 = [ 1 λ 2 λ 3 ] T {displaystyle mathbf {v} _{lambda _{2}}={begin{bmatrix}1&lambda _{2}&lambda _{3}end{bmatrix}}^{textsf {T }}}

et v λ 3 = [ 1 λ 3 λ 2 ] T {displaystyle mathbf {v} _{lambda _{3}}={begin{bmatrix}1&lambda _{3}&lambda _{2}end{bmatrix}}^{textsf {T }}}

de valeurs propres λ 2 et λ 3 , respectivement. Les deux vecteurs propres complexes apparaissent également dans une paire conjuguée complexe,

v λ 2 = v λ 3 ∗ . {displaystyle mathbf {v} _{lambda _{2}}=mathbf {v} _{lambda _{3}}^{*}.}

Les matrices avec des entrées uniquement le long de la diagonale principale sont appelées Matrices diagonales . Les valeurs propres d’une matrice diagonale sont les éléments diagonaux eux-mêmes. Considérez la matrice

A = [ 1 0 0 0 2 0 0 0 3 ] . {displaystyle A={begin{bmatrix}1&0&0\0&2&0\0&0&3end{bmatrix}}.}

Le polynôme caractéristique de A est

| A − λ I | = ( 1 − λ ) ( 2 − λ ) ( 3 − λ ) , {displaystyle |A-lambda I|=(1-lambda )(2-lambda )(3-lambda ),}

qui a pour racines λ 1 = 1 , λ 2 = 2 et λ 3 = 3 . Ces racines sont les éléments diagonaux ainsi que les valeurs propres de A .

Chaque élément diagonal correspond à un vecteur propre dont la seule composante non nulle est dans la même ligne que cet élément diagonal. Dans l’exemple, les valeurs propres correspondent aux vecteurs propres,

v λ 1 = [ 1 0 0 ] , v λ 2 = [ 0 1 0 ] , v λ 3 = [ 0 0 1 ] , {displaystyle mathbf {v} _{lambda _{1}}={begin{bmatrix}1\0\0end{bmatrix}},quad mathbf {v} _{lambda _ {2}}={begin{bmatrix}0\1\0end{bmatrix}},quad mathbf {v} _{lambda _{3}}={begin{bmatrix}0 �\1end{bmatrice}},}

respectivement, ainsi que des multiples scalaires de ces vecteurs.

Exemple de matrice triangulaire

Une matrice dont les éléments au-dessus de la diagonale principale sont tous nuls est appelée matrice triangulaire inférieure , tandis qu’une matrice dont les éléments au-dessous de la diagonale principale sont tous nuls est appelée matrice triangulaire supérieure . Comme pour les Matrices diagonales, les valeurs propres des matrices triangulaires sont les éléments de la diagonale principale.

Considérons la matrice triangulaire inférieure,

A = [ 1 0 0 1 2 0 2 3 3 ] . {displaystyle A={begin{bmatrix}1&0&0\1&2&0\2&3&3end{bmatrix}}.}

Le polynôme caractéristique de A est

| A − λ I | = ( 1 − λ ) ( 2 − λ ) ( 3 − λ ) , {displaystyle |A-lambda I|=(1-lambda )(2-lambda )(3-lambda ),}

qui a pour racines λ 1 = 1 , λ 2 = 2 et λ 3 = 3 . Ces racines sont les éléments diagonaux ainsi que les valeurs propres de A .

Ces valeurs propres correspondent aux vecteurs propres,

v λ 1 = [ 1 − 1 1 2 ] , v λ 2 = [ 0 1 − 3 ] , v λ 3 = [ 0 0 1 ] , {displaystyle mathbf {v} _{lambda _{1}}={begin{bmatrix}1\-1\{frac {1}{2}}end{bmatrix}},quad mathbf {v} _{lambda _{2}}={begin{bmatrix}0\1\-3end{bmatrix}},quad mathbf {v} _{lambda _{3 }}={begin{bmatrice}0\0\1end{bmatrice}},}

respectivement, ainsi que des multiples scalaires de ces vecteurs.

Exemple de matrice avec valeurs propres répétées

Comme dans l’exemple précédent, la matrice triangulaire inférieure

A = [ 2 0 0 0 1 2 0 0 0 1 3 0 0 0 1 3 ] , {displaystyle A={begin{bmatrix}2&0&0&0\1&2&0&0\0&1&3&0\0&0&1&3end{bmatrix}},}

a un polynôme caractéristique qui est le produit de ses éléments diagonaux,

| A − λ I | = | 2 − λ 0 0 0 1 2 − λ 0 0 0 1 3 − λ 0 0 0 1 3 − λ | = ( 2 − λ ) 2 ( 3 − λ ) 2 . {displaystyle |A-lambda I|={begin{vmatrix}2-lambda &0&0&0\1&2-lambda &0&0\0&1&3-lambda &0\0&0&1&3-lambda end{vmatrix}}=( 2-lambda )^{2}(3-lambda )^{2}.}

Les racines de ce polynôme, et donc les valeurs propres, sont 2 et 3. La multiplicité algébrique de chaque valeur propre est 2 ; en d’autres termes, ce sont toutes deux des racines doubles. La somme des multiplicités algébriques de toutes les valeurs propres distinctes est μ A = 4 = n , l’ordre du polynôme caractéristique et la dimension de A .

D’autre part, la multiplicité géométrique de la valeur propre 2 n’est que de 1, car son espace propre est couvert par un seul vecteur [ 0 1 − 1 1 ] T {displaystyle {begin{bmatrix}0&1&-1&1end{bmatrix}}^{textsf {T}}}

et est donc unidimensionnel. De même, la multiplicité géométrique de la valeur propre 3 est 1 car son espace propre est couvert par un seul vecteur [ 0 0 0 1 ] T {displaystyle {begin{bmatrix}0&0&0&1end{bmatrix}}^{textsf {T}}}

. La multiplicité géométrique totale γ A est de 2, ce qui est la plus petite possible pour une matrice à deux valeurs propres distinctes. Les multiplicités géométriques sont définies dans une section ultérieure.

Identité vecteur propre-valeur propre

Pour une matrice hermitienne , la norme au carré de la j ème composante d’ un vecteur propre normalisé peut être calculée en utilisant uniquement les valeurs propres de la matrice et les valeurs propres de la matrice mineure correspondante ,

| v i , j | 2 = ∏ k ( λ i − λ k ( M j ) ) ∏ k ≠ i ( λ i − λ k ) , {displaystyle |v_{i,j}|^{2}={frac {prod _{k}{(lambda _{i}-lambda _{k}(M_{j}))}} {prod _{kneq i}{(lambda _{i}-lambda _{k})}}},}

où M j {textstyle M_{j}}

est la sous- matrice formée en supprimant la jème ligne et colonne de la matrice d’origine. [33] [34] [35] Cette identité s’étend aussi aux matrices diagonalisables et a été redécouverte plusieurs fois dans la littérature. [34]

Valeurs propres et fonctions propres des opérateurs différentiels

Les définitions de valeur propre et de vecteurs propres d’une transformation linéaire T restent valables même si l’espace vectoriel sous-jacent est un espace de Hilbert ou de Banach de dimension infinie . Une classe largement utilisée de transformations linéaires agissant sur des espaces de dimension infinie sont les opérateurs différentiels sur les espaces fonctionnels . Soit D un opérateur différentiel linéaire sur l’espace C ∞ des fonctions réelles infiniment différentiables d’un argument réel t . L’équation aux valeurs propres pour D est l’ équation différentielle

D f ( t ) = λ f ( t ) {displaystyle Df(t)=lambda f(t)}

Les fonctions qui satisfont cette équation sont des vecteurs propres de D et sont communément appelées fonctions propres .

Exemple d’opérateur dérivé

Considérez l’opérateur dérivé d d t {displaystyle {tfrac {d}{dt}}}

avec équation aux valeurs propres

d d t f ( t ) = λ f ( t ) . {displaystyle {frac {d}{dt}}f(t)=lambda f(t).}

Cette équation différentielle peut être résolue en multipliant les deux côtés par dt / f ( t ) et en intégrant. Sa solution, la fonction exponentielle

f ( t ) = f ( 0 ) e λ t , {displaystyle f(t)=f(0)e^{lambda t},}

est la fonction propre de l’opérateur dérivé. Dans ce cas, la fonction propre est elle-même fonction de sa valeur propre associée. En particulier, pour λ = 0 la fonction propre f ( t ) est une constante.

L’article principal sur les fonctions propres donne d’autres exemples.

Définition générale

Le concept de valeurs propres et de vecteurs propres s’étend naturellement aux transformations linéaires arbitraires sur des espaces vectoriels arbitraires. Soit V un espace vectoriel quelconque sur un corps K de scalaires , et soit T une transformation linéaire appliquant V dans V ,

T : V → V . {displaystyle T:Và V.}

On dit qu’un vecteur non nul v ∈ V est un vecteur propre de T si et seulement s’il existe un scalaire λ ∈ K tel que

T ( v ) = λ v . {displaystyle T(mathbf {v} )=lambda mathbf {v} .}  |

( 5 ) |

Cette équation est appelée équation aux valeurs propres pour T , et le scalaire λ est la valeur propre de T correspondant au vecteur propre v . T ( v ) est le résultat de l’application de la transformation T au vecteur v , tandis que λ v est le produit du scalaire λ avec v . [36] [37]

Espaces propres, multiplicité géométrique et base propre

Étant donné une valeur propre λ , considérons l’ensemble

E = { v : T ( v ) = λ v } , {displaystyle E=left{mathbf {v} :T(mathbf {v} )=lambda mathbf {v} right},}

qui est l’union du vecteur nul avec l’ensemble de tous les vecteurs propres associés à λ . E est appelé espace propre ou espace caractéristique de T associé à λ .

Par définition d’une transformation linéaire,

T ( x + y ) = T ( x ) + T ( y ) , T ( α x ) = α T ( x ) , {displaystyle {begin{aligned}T(mathbf {x} +mathbf {y} )&=T(mathbf {x} )+T(mathbf {y} ),\T(alpha mathbf {x} )&=alpha T(mathbf {x} ),end{aligné}}}

pour x , y ∈ V et α ∈ K . Donc, si u et v sont des vecteurs propres de T associés à la valeur propre λ , soit u , v ∈ E , alors

T ( u + v ) = λ ( u + v ) , T ( α v ) = λ ( α v ) . {displaystyle {begin{aligned}T(mathbf {u} +mathbf {v} )&=lambda (mathbf {u} +mathbf {v} ),\T(alpha mathbf { v} )&=lambda (alpha mathbf {v} ).end{aligné}}}

Ainsi, u + v et α v sont soit nuls, soit des vecteurs propres de T associés à λ , à savoir u + v , α v ∈ E , et E est fermé par addition et multiplication scalaire. L’espace propre E associé à λ est donc un sous-espace linéaire de V . [38] Si ce sous-espace a la dimension 1, on l’appelle parfois une ligne propre . [39]

La multiplicité géométrique γ T ( λ ) d’une valeur propre λ est la dimension de l’espace propre associé à λ , c’est-à-dire le nombre maximum de vecteurs propres linéairement indépendants associés à cette valeur propre. [9] [26] Selon la définition des valeurs propres et des vecteurs propres, γ T ( λ ) ≥ 1 car chaque valeur propre a au moins un vecteur propre.

Les espaces propres de T forment toujours une somme directe . Par conséquent, les vecteurs propres de différentes valeurs propres sont toujours linéairement indépendants. Par conséquent, la somme des dimensions des espaces propres ne peut pas dépasser la dimension n de l’espace vectoriel sur lequel T opère, et il ne peut y avoir plus de n valeurs propres distinctes. [e]

Tout sous-espace couvert par des vecteurs propres de T est un sous- espace invariant de T , et la restriction de T à un tel sous-espace est diagonalisable. De plus, si l’ensemble de l’espace vectoriel V peut être couvert par les vecteurs propres de T , ou de manière équivalente si la somme directe des espaces propres associés à toutes les valeurs propres de T est l’ensemble de l’espace vectoriel V , alors une base de V appelée base propre peut être formé de vecteurs propres linéairement indépendants de T . Lorsque T admet une base propre, T est diagonalisable.

Théorie spectrale

Si λ est une valeur propre de T , alors l’opérateur ( T − λI ) n’est pas univoque, et donc son inverse ( T − λI ) −1 n’existe pas. L’inverse est vrai pour les espaces vectoriels de dimension finie, mais pas pour les espaces vectoriels de dimension infinie. En général, l’opérateur ( T − λI ) peut ne pas avoir d’inverse même si λ n’est pas une valeur propre.

Pour cette raison, dans l’analyse fonctionnelle, les valeurs propres peuvent être généralisées au spectre d’un opérateur linéaire T comme l’ensemble de tous les scalaires λ pour lesquels l’opérateur ( T – λI ) n’a pas d’ inverse borné . Le spectre d’un opérateur contient toujours toutes ses valeurs propres mais n’est pas limité à elles.

Algèbres associatives et théorie des représentations

On peut généraliser l’objet algébrique qui agit sur l’espace vectoriel, en remplaçant un seul opérateur agissant sur un espace vectoriel par une représentation algébrique – une algèbre associative agissant sur un module . L’étude de telles actions est du domaine de la théorie des représentations .

Le concept théorique de représentation du poids est un analogue des valeurs propres, tandis que les vecteurs de poids et les espaces de poids sont les analogues des vecteurs propres et des espaces propres, respectivement.

Équations dynamiques

Les équations aux différences les plus simples ont la forme

x t = a 1 x t − 1 + a 2 x t − 2 + ⋯ + a k x t − k . {displaystyle x_{t}=a_{1}x_{t-1}+a_{2}x_{t-2}+cdots +a_{k}x_{tk}.}

La solution de cette équation pour x en fonction de t est trouvée en utilisant son équation caractéristique

λ k − a 1 λ k − 1 − a 2 λ k − 2 − ⋯ − a k − 1 λ − a k = 0 , {displaystyle lambda ^{k}-a_{1}lambda ^{k-1}-a_{2}lambda ^{k-2}-cdots -a_{k-1}lambda -a_{ k}=0,}

qui peuvent être trouvés en empilant dans une matrice un ensemble d’équations composé de l’Équation de différence ci-dessus et des k – 1 équations x t − 1 = x t − 1 , … , x t − k + 1 = x t − k + 1 , {displaystyle x_{t-1}=x_{t-1}, dots , x_{t-k+1}=x_{t-k+1},}

donnant un système k -dimensionnel du premier ordre dans le vecteur variable empilé [ x t ⋯ x t − k + 1 ] {displaystyle {begin{bmatrix}x_{t}&cdots &x_{t-k+1}end{bmatrix}}}

en termes de sa valeur une fois retardée, et en prenant l’équation caractéristique de la matrice de ce système. Cette équation donne k racines caractéristiques λ 1 , … , λ k , {displaystyle lambda _{1},,ldots ,,lambda _{k},}

à utiliser dans l’équation de solution

x t = c 1 λ 1 t + ⋯ + c k λ k t . {displaystyle x_{t}=c_{1}lambda _{1}^{t}+cdots +c_{k}lambda _{k}^{t}.}

Une procédure similaire est utilisée pour résoudre une équation différentielle de la forme

d k x d t k + a k − 1 d k − 1 x d t k − 1 + ⋯ + a 1 d x d t + a 0 x = 0. {displaystyle {frac {d^{k}x}{dt^{k}}}+a_{k-1}{frac {d^{k-1}x}{dt^{k-1} }}+cdots +a_{1}{frac {dx}{dt}}+a_{0}x=0.}

Calcul

Le calcul des valeurs propres et des vecteurs propres est un sujet où la théorie, telle qu’elle est présentée dans les manuels élémentaires d’algèbre linéaire, est souvent très éloignée de la pratique.

Méthode classique

La méthode classique consiste à trouver d’abord les valeurs propres, puis à calculer les vecteurs propres pour chaque valeur propre. Il est à plusieurs égards mal adapté à l’arithmétique non exacte telle que la virgule flottante .

Valeurs propres

Les valeurs propres d’une matrice A {displaystyle A}

peut être déterminé en trouvant les racines du polynôme caractéristique. C’est facile pour 2 × 2 {displaystyle 2fois 2}

matrices, mais la difficulté augmente rapidement avec la taille de la matrice.

En théorie, les coefficients du polynôme caractéristique peuvent être calculés exactement, puisqu’il s’agit de sommes de produits d’éléments de matrice ; et il existe des algorithmes qui peuvent trouver toutes les racines d’un polynôme de degré arbitraire avec n’importe quelle Précision requise . [40] Cependant, cette approche n’est pas viable en pratique car les coefficients seraient contaminés par des erreurs d’arrondi inévitables , et les racines d’un polynôme peuvent être une fonction extrêmement sensible des coefficients (comme illustré par le polynôme de Wilkinson ). [40] Même pour les matrices dont les éléments sont des entiers, le calcul devient non trivial, car les sommes sont très longues ; le terme constant est le déterminant , qui pour un n × n {displaystyle nfois n}

est une somme de n ! {displaystyle n !}

différents produits. [F]

Les formules algébriques explicites pour les racines d’un polynôme n’existent que si le degré n {displaystyle n}

est de 4 ou moins. Selon le théorème d’ Abel-Ruffini, il n’existe pas de formule algébrique générale, explicite et exacte pour les racines d’un polynôme de degré 5 ou plus. (La généralité est importante car tout polynôme de degré n {displaystyle n}

est le polynôme caractéristique d’une matrice compagne d’ordre n {displaystyle n}

.) Par conséquent, pour les matrices d’ordre 5 ou plus, les valeurs propres et les vecteurs propres ne peuvent pas être obtenus par une formule algébrique explicite, et doivent donc être calculés par des méthodes numériques approchées . Même la formule exacte pour les racines d’un polynôme de degré 3 est numériquement impraticable.

Vecteurs propres

Une fois que la valeur (exacte) d’une valeur propre est connue, les vecteurs propres correspondants peuvent être trouvés en trouvant des solutions non nulles de l’équation aux valeurs propres, qui devient un système d’équations linéaires à coefficients connus. Par exemple, une fois que l’on sait que 6 est une valeur propre de la matrice

A = [ 4 1 6 3 ] {displaystyle A={begin{bmatrix}4&1\6&3end{bmatrix}}}

on peut trouver ses vecteurs propres en résolvant l’équation A v = 6 v {displaystyle Av=6v}

, C’est

[ 4 1 6 3 ] [ x y ] = 6 ⋅ [ x y ] {displaystyle {begin{bmatrix}4&1\6&3end{bmatrix}}{begin{bmatrix}x\yend{bmatrix}}=6cdot {begin{bmatrix}x\y fin{bmatrice}}}

Cette équation matricielle est équivalente à deux équations linéaires

{ 4 x + y = 6 x 6 x + 3 y = 6 y {displaystyle left{{begin{aligned}4x+y&=6x\6x+3y&=6yend{aligned}}right.}

C’est { − 2 x + y = 0 6 x − 3 y = 0 {displaystyle left{{begin{aligned}-2x+y&=0\6x-3y&=0end{aligned}}right.}

Les deux équations se réduisent à la seule équation linéaire y = 2 x {displaystyle y=2x}

. Par conséquent, tout vecteur de la forme [ a 2 a ] T {displaystyle {begin{bmatrix}a&2aend{bmatrix}}^{textsf {T}}}

, pour tout nombre réel non nul a {displaystyle a}

, est un vecteur propre de A {displaystyle A}

avec valeur propre λ = 6 {displaystylelambda =6}

.

La matrice A {displaystyle A}

ci-dessus a une autre valeur propre λ = 1 {displaystylelambda =1}

. Un calcul similaire montre que les vecteurs propres correspondants sont les solutions non nulles de 3 x + y = 0 {displaystyle 3x+y=0}

, c’est-à-dire tout vecteur de la forme [ b − 3 b ] T {displaystyle {begin{bmatrix}b&-3bend{bmatrix}}^{textsf {T}}}

, pour tout nombre réel non nul b {displaystyle b}

.

Méthodes itératives simples

L’approche inverse, consistant à rechercher d’abord les vecteurs propres, puis à déterminer chaque valeur propre à partir de son vecteur propre, s’avère beaucoup plus facile à gérer pour les ordinateurs. L’algorithme le plus simple ici consiste à choisir un vecteur de départ arbitraire, puis à le multiplier à plusieurs reprises avec la matrice (en normalisant éventuellement le vecteur pour conserver ses éléments de taille raisonnable); cela fait converger le vecteur vers un vecteur propre. Une variante consiste à multiplier le vecteur par ( A − μ I ) − 1 {displaystyle (A-mu I)^{-1}}

; cela le fait converger vers un vecteur propre de la valeur propre la plus proche de μ ∈ C {displaystyle mu in mathbb {C} }

.

Si v {displaystyle mathbf {v} }

est (une bonne approximation de) un vecteur propre de A {displaystyle A}

, alors la valeur propre correspondante peut être calculée comme

λ = v ∗ A v v ∗ v {displaystyle lambda ={frac {mathbf {v} ^{*}Amathbf {v} }{mathbf {v} ^{*}mathbf {v} }}}

où v ∗ {displaystyle mathbf {v} ^{*}}

désigne la transposée conjuguée de v {displaystyle mathbf {v} }

.

Méthodes modernes

Des méthodes efficaces et précises pour calculer les valeurs propres et les vecteurs propres de matrices arbitraires n’étaient pas connues jusqu’à la conception de l’ algorithme QR en 1961. [40] La combinaison de la transformation Householder avec la décomposition LU donne un algorithme avec une meilleure convergence que l’algorithme QR. [ citation nécessaire ] Pour les grandes matrices clairsemées hermitiennes , l’ algorithme de Lanczos est un exemple d’une méthode itérative efficace pour calculer les valeurs propres et les vecteurs propres, parmi plusieurs autres possibilités. [40]

La plupart des méthodes numériques qui calculent les valeurs propres d’une matrice déterminent également un ensemble de vecteurs propres correspondants en tant que sous-produit du calcul, bien que parfois les implémenteurs choisissent de supprimer les informations de vecteur propre dès qu’elles ne sont plus nécessaires.

Applications

Valeurs propres des transformations géométriques

Le tableau suivant présente quelques exemples de transformations dans le plan avec leurs matrices 2 × 2, leurs valeurs propres et leurs vecteurs propres.

| Mise à l’échelle | Mise à l’échelle inégale | Rotation | Cisaillement horizontal | Rotation hyperbolique | |

|---|---|---|---|---|---|

| Illustration |   |

|

|

|

|

| Matrice | [ k 0 0 k ] {displaystyle {begin{bmatrix}k&0\0&kend{bmatrix}}}  |

[ k 1 0 0 k 2 ] {displaystyle {begin{bmatrix}k_{1}&0\0&k_{2}end{bmatrix}}}  |

[ cos θ − sin θ sin θ cos θ ] {displaystyle {begin{bmatrix}cos theta &-sin theta \sin theta &cos theta end{bmatrix}}}  |

[ 1 k 0 1 ] {displaystyle {begin{bmatrix}1&k\0&1end{bmatrix}}}  |

[ cosh φ sinh φ sinh φ cosh φ ] {displaystyle {begin{bmatrix}cosh varphi &sinh varphi \sinh varphi &cosh varphi end{bmatrix}}}  |

| Polynôme caractéristique | ( λ − k ) 2 { style d’affichage ( lambda -k) ^ {2}}  |

( λ − k 1 ) ( λ − k 2 ) {displaystyle (lambda -k_{1})(lambda -k_{2})}  |

λ 2 − 2 cos ( θ ) λ + 1 {displaystyle lambda ^{2}-2cos(theta)lambda +1}  |

( λ − 1 ) 2 {displaystyle (lambda -1)^{2}}  |

λ 2 − 2 cosh ( φ ) λ + 1 {displaystyle lambda ^{2}-2cosh(varphi)lambda +1}  |

Valeurs propres, λ i {displaystyle lambda _{i}}  |

λ 1 = λ 2 = k {displaystyle lambda _{1}=lambda _{2}=k}  |

λ 1 = k 1 λ 2 = k 2 {displaystyle {begin{aligned}lambda _{1}&=k_{1}\lambda _{2}&=k_{2}end{aligned}}}  |

λ 1 = e i θ = cos θ + i sin θ λ 2 = e − i θ = cos θ − i sin θ {displaystyle {begin{aligned}lambda _{1}&=e^{itheta }\&=cos theta +isin theta \lambda _{2}&=e^ {-itheta }\&=cos theta -isin theta end{aligné}}}  |

λ 1 = λ 2 = 1 {displaystyle lambda _{1}=lambda _{2}=1}  |

λ 1 = e φ = cosh φ + sinh φ λ 2 = e − φ = cosh φ − sinh φ {displaystyle {begin{aligned}lambda _{1}&=e^{varphi }\&=cosh varphi +sinh varphi \lambda _{2}&=e^{- varphi }\&=cosh varphi -sinh varphi end{aligné}}}  |

| Multi algébrique . , μ i = μ ( λ i ) {displaystyle mu _{i}=mu (lambda _{i})}  |

μ 1 = 2 {displaystylemu _{1}=2}  |

μ 1 = 1 μ 2 = 1 {displaystyle {begin{aligné}mu _{1}&=1\mu _{2}&=1end{aligné}}}  |

μ 1 = 1 μ 2 = 1 {displaystyle {begin{aligné}mu _{1}&=1\mu _{2}&=1end{aligné}}}  |

μ 1 = 2 {displaystylemu _{1}=2}  |

μ 1 = 1 μ 2 = 1 {displaystyle {begin{aligné}mu _{1}&=1\mu _{2}&=1end{aligné}}}  |

| Multi géométrique . , γ i = γ ( λ i ) {displaystyle gamma _{i}=gamma (lambda _{i})}  |

γ 1 = 2 {displaystylegamma _{1}=2}  |

γ 1 = 1 γ 2 = 1 {displaystyle {begin{aligné}gamma _{1}&=1\gamma _{2}&=1end{aligné}}}  |

γ 1 = 1 γ 2 = 1 {displaystyle {begin{aligné}gamma _{1}&=1\gamma _{2}&=1end{aligné}}}  |

γ 1 = 1 {displaystylegamma _{1}=1}  |

γ 1 = 1 γ 2 = 1 {displaystyle {begin{aligné}gamma _{1}&=1\gamma _{2}&=1end{aligné}}}  |

| Vecteurs propres | Tous les vecteurs non nuls | u 1 = [ 1 0 ] u 2 = [ 0 1 ] {displaystyle {begin{aligned}mathbf {u} _{1}&={begin{bmatrix}1\0end{bmatrix}}\mathbf {u} _{2}&={ begin{bmatrix}0\1end{bmatrix}}end{aligné}}}  |

u 1 = [ 1 − i ] u 2 = [ 1 + i ] {displaystyle {begin{aligned}mathbf {u} _{1}&={begin{bmatrix}1\-iend{bmatrix}}\mathbf {u} _{2}&= {begin{bmatrix}1\+iend{bmatrix}}end{aligned}}}  |

u 1 = [ 1 0 ] {displaystyle mathbf {u} _{1}={begin{bmatrix}1\0end{bmatrix}}}  |

u 1 = [ 1 1 ] u 2 = [ 1 − 1 ] {displaystyle {begin{aligned}mathbf {u} _{1}&={begin{bmatrix}1\1end{bmatrix}}\mathbf {u} _{2}&={ begin{bmatrice}1\-1end{bmatrice}}end{aligné}}}  |

L’équation caractéristique d’une rotation est une équation quadratique à discriminant D = − 4 ( sin θ ) 2 {displaystyle D=-4(sin theta )^{2}}

, qui est un nombre négatif chaque fois que θ n’est pas un multiple entier de 180°. Donc, sauf ces cas particuliers, les deux valeurs propres sont des nombres complexes, cos θ ± i sin θ {displaystyle cos theta pm isin theta }

Une transformation linéaire qui transforme un carré en un rectangle de la même zone (un squeeze mapping ) a des valeurs propres réciproques.

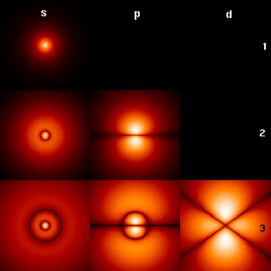

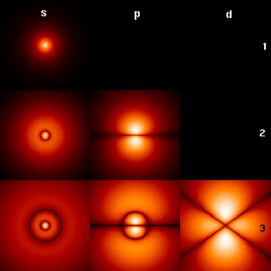

Équation de Schrödinger

Les fonctions d’ onde associées aux états liés d’un électron dans un atome d’hydrogène peuvent être considérées comme les vecteurs propres de l’ hamiltonien de l’atome d’hydrogène ainsi que de l’ opérateur de moment cinétique . Ils sont associés à des valeurs propres interprétées comme leurs énergies (croissantes vers le bas : n = 1 , 2 , 3 , … {displaystyle n=1,,2,,3,,ldots }

Les fonctions d’ onde associées aux états liés d’un électron dans un atome d’hydrogène peuvent être considérées comme les vecteurs propres de l’ hamiltonien de l’atome d’hydrogène ainsi que de l’ opérateur de moment cinétique . Ils sont associés à des valeurs propres interprétées comme leurs énergies (croissantes vers le bas : n = 1 , 2 , 3 , … {displaystyle n=1,,2,,3,,ldots }

) et le moment cinétique (croissant sur : s, p, d, …). L’illustration montre le carré de la valeur absolue des fonctions d’onde. Les zones plus claires correspondent à une densité de probabilité plus élevée pour une mesure de position . Le centre de chaque figure est le noyau atomique , un proton .

Un exemple d’équation aux valeurs propres où la transformation T {displaystyle T}

est représentée en termes d’opérateur différentiel est l’ équation de Schrödinger indépendante du temps en mécanique quantique :

H ψ E = E ψ E {displaystyle Hpsi _{E}=Epsi _{E},}

où H {displaystyle H}

, l’ hamiltonien , est un opérateur différentiel du second ordre et ψ E {displaystyle psi _{E}}

, la fonction d’ onde , est l’une de ses fonctions propres correspondant à la valeur propre E {displaystyle E}

, interprété comme son énergie .

Cependant, dans le cas où l’on ne s’intéresse qu’aux solutions des états liés de l’équation de Schrödinger, on cherche ψ E {displaystyle psi _{E}}

dans l’espace des fonctions de carré intégrable . Puisque cet espace est un espace de Hilbert avec un produit scalaire bien défini , on peut introduire un ensemble de base dans lequel ψ E {displaystyle psi _{E}}

et H {displaystyle H}

peut être représenté respectivement par un tableau unidimensionnel (c’est-à-dire un vecteur) et une matrice. Cela permet de représenter l’équation de Schrödinger sous forme matricielle.

La notation bra–ket est souvent utilisée dans ce contexte. Un vecteur, qui représente un état du système, dans l’espace de Hilbert des fonctions carrées intégrables est représenté par | Ψ E ⟩ {displaystyle |Psi _{E}rangle }

. Dans cette notation, l’équation de Schrödinger est :

H | Ψ E ⟩ = E | Ψ E ⟩ {displaystyle H|Psi _{E}rangle =E|Psi _{E}rangle }

où | Ψ E ⟩ {displaystyle |Psi _{E}rangle }

est un état propre de H {displaystyle H}

et E {displaystyle E}

représente la valeur propre. H {displaystyle H}

est un opérateur auto-adjoint observable , l’analogue de dimension infinie des matrices hermitiennes. Comme dans le cas de la matrice, dans l’équation ci-dessus H | Ψ E ⟩ {displaystyle H|Psi _{E}rangle }

s’entend comme le vecteur obtenu par application de la transformation H {displaystyle H}

pour | Ψ E ⟩ {displaystyle |Psi _{E}rangle }

.

Transport des vagues

La lumière , les ondes acoustiques et les micro – ondes sont dispersées au hasard de nombreuses fois lorsqu’elles traversent un système statique désordonné . Même si la diffusion multiple randomise à plusieurs reprises les ondes, le transport d’ondes finalement cohérent à travers le système est un processus déterministe qui peut être décrit par une matrice de transmission de champ t {displaystyle mathbf {t} }

. [41] [42] Les vecteurs propres de l’opérateur de transmission t † t {displaystyle mathbf {t} ^{poignard}mathbf {t}}

forment un ensemble de fronts d’onde d’entrée spécifiques au désordre qui permettent aux ondes de se coupler dans les canaux propres du système désordonné : les voies indépendantes que les ondes peuvent parcourir à travers le système. Les valeurs propres, τ {displaystyletau}

, de t † t {displaystyle mathbf {t} ^{poignard}mathbf {t}}

correspondent à la transmittance d’intensité associée à chaque canal propre. Une des propriétés remarquables de l’opérateur de transmission des systèmes diffusifs est leur distribution bimodale des valeurs propres avec τ max = 1 {displaystyle tau _{max }=1}

et τ min = 0 {displaystyle tau _{min }=0}

. [42] De plus, l’une des propriétés frappantes des canaux propres ouverts, au-delà de la transmission parfaite, est le profil spatial statistiquement robuste des canaux propres. [43]

Orbitales moléculaires

En mécanique quantique , et en particulier en physique atomique et moléculaire , au sein de la théorie Hartree-Fock , les orbitales atomiques et moléculaires peuvent être définies par les vecteurs propres de l’ opérateur de Fock . Les valeurs propres correspondantes sont interprétées comme des potentiels d’ionisation via le théorème de Koopmans . Dans ce cas, le terme vecteur propre est utilisé dans un sens un peu plus général, puisque l’opérateur de Fock dépend explicitement des orbitales et de leurs valeurs propres. Ainsi, si l’on veut souligner cet aspect, on parle de problèmes aux valeurs propres non linéaires. Ces équations sont généralement résolues par une itérationprocédure, appelée dans ce cas méthode de champ auto-cohérente . En chimie quantique , on représente souvent l’équation de Hartree-Fock dans un ensemble de bases non orthogonales . Cette représentation particulière est un problème généralisé aux valeurs propres appelé équations de Roothaan .

Géologie et glaciologie

En géologie , en particulier dans l’étude du till glaciaire , les vecteurs propres et les valeurs propres sont utilisés comme méthode par laquelle une masse d’informations sur l’orientation et le pendage des constituants d’un tissu clastique peut être résumée dans un espace 3D par six nombres. Sur le terrain, un géologue peut collecter de telles données pour des centaines ou des milliers de clastes dans un échantillon de sol, qui ne peuvent être comparées que graphiquement, comme dans un diagramme Tri-Plot (Sneed et Folk), [44] [45] ou comme un Stéréonet sur un Wulff Net. [46]

La sortie du tenseur d’orientation est dans les trois axes orthogonaux (perpendiculaires) de l’espace. Les trois vecteurs propres sont ordonnés v 1 , v 2 , v 3 {displaystyle mathbf {v} _{1},mathbf {v} _{2},mathbf {v} _{3}}

par leurs valeurs propres E 1 ≥ E 2 ≥ E 3 {displaystyle E_{1}geq E_{2}geq E_{3}}

; [47] v 1 {displaystyle mathbf {v} _{1}}

est alors l’orientation / le pendage primaire du clast, v 2 {displaystyle mathbf {v} _{2}}

est le secondaire et v 3 {displaystyle mathbf {v} _{3}}

est le tertiaire, en termes de force. L’orientation clast est définie comme la direction du vecteur propre, sur une rose des vents de 360° . Le pendage est mesuré comme la valeur propre, le module du tenseur : il est évalué de 0° (pas de pendage) à 90° (vertical). Les valeurs relatives de E 1 {displaystyle E_{1}}

, E 2 {displaystyle E_{2}}

, et E 3 {displaystyle E_{3}}

sont dictés par la nature du tissu sédimentaire. Si E 1 = E 2 = E 3 {displaystyle E_{1}=E_{2}=E_{3}}

, le tissu est dit isotrope. Si E 1 = E 2 > E 3 {displaystyle E_{1}=E_{2}>E_{3}}

, le tissu est dit plan. Si E 1 > E 2 > E 3 {displaystyle E_{1}>E_{2}>E_{3}}

, le tissu est dit linéaire. [48]

Analyse des composants principaux

PCA de la distribution gaussienne multivariée centrée sur ( 1 , 3 ) {displaystyle (1,3)}

PCA de la distribution gaussienne multivariée centrée sur ( 1 , 3 ) {displaystyle (1,3)}

avec un écart-type de 3 à peu près ( 0.878 , 0.478 ) {displaystyle (0.878,0.478)}

direction et de 1 dans la direction orthogonale. Les vecteurs représentés sont des vecteurs propres unitaires de la matrice de covariance (symétrique, positive-semi-définie) mis à l’échelle par la racine carrée de la valeur propre correspondante. Tout comme dans le cas unidimensionnel, la racine carrée est prise parce que l’ écart type est plus facilement visualisé que la variance .

La décomposition propre d’une matrice semi-définie positive symétrique (PSD) donne une base orthogonale de vecteurs propres, dont chacun a une valeur propre non négative. La décomposition orthogonale d’une matrice PSD est utilisée dans l’analyse multivariée , où les matrices de covariance d’échantillon sont PSD. Cette décomposition orthogonale est appelée analyse en composantes principales (ACP) en statistique. L’ACP étudie les relations linéaires entre les variables. L’ACP est effectuée sur la matrice de covariance ou la matrice de corrélation (dans laquelle chaque variable est mise à l’échelle pour avoir son variance de l’échantillon égale à un). Pour la matrice de covariance ou de corrélation, les vecteurs propres correspondent aux composantes principales et les valeurs propres à la variance expliquée par les composantes principales. L’analyse en composantes principales de la matrice de corrélation fournit une base orthogonale pour l’espace des données observées : dans cette base, les valeurs propres les plus grandes correspondent aux composantes principales qui sont associées à la plupart de la covariabilité entre un certain nombre de données observées.

L’ analyse en composantes principales est utilisée comme moyen de réduction de la dimensionnalité dans l’ étude de grands ensembles de données , tels que ceux rencontrés en bio – informatique . Dans la méthodologie Q , les valeurs propres de la matrice de corrélation déterminent le jugement de signification pratique du Q-méthodologiste (qui diffère de la signification statistique des tests d’ hypothèses ; cf. critères de détermination du nombre de facteurs ). Plus généralement, l’analyse en composantes principales peut être utilisée comme méthode d’ analyse factorielle dans la modélisation par équation structurelle .

Analyse vibratoire

Forme modale d’un diapason à fréquence propre 440,09 Hz

Forme modale d’un diapason à fréquence propre 440,09 Hz

Les problèmes de valeurs propres surviennent naturellement dans l’Analyse vibratoire des structures mécaniques à plusieurs degrés de liberté . Les valeurs propres sont les fréquences propres (ou fréquences propres) de vibration, et les vecteurs propres sont les formes de ces modes vibrationnels. En particulier, les vibrations non amorties sont régies par

m x ̈ + k x = 0 {displaystyle m{ddot {x}}+kx=0}

ou alors

m x ̈ = − k x {displaystyle m{ddot {x}}=-kx}

c’est-à-dire que l’accélération est proportionnelle à la position (c’est-à-dire que nous nous attendons à x {style d’affichage x}

être sinusoïdale dans le temps).

Dans n {displaystyle n}

dimensions, m {displaystyle m}

devient un matrice de masse et k {displaystyle k}

une matrice de rigidité . Les solutions admissibles sont alors une combinaison linéaire de solutions au problème aux valeurs propres généralisé

k x = ω 2 m x {displaystyle kx=omega ^{2}mx}

où ω 2 {displaystyle oméga ^{2}}

est la valeur propre et ω {displaystyle oméga}

est la fréquence angulaire (imaginaire) . Les principaux modes de vibration sont différents des principaux modes de compliance, qui sont les vecteurs propres de k {displaystyle k}

seule. De plus, les vibrations amorties , régies par

m x ̈ + c x ̇ + k x = 0 {displaystyle m{ddot {x}}+c{dot {x}}+kx=0}

conduit à un problème aux valeurs propres dit quadratique ,

( ω 2 m + ω c + k ) x = 0. {displaystyle left(omega ^{2}m+omega c+kright)x=0.}

Cela peut être réduit à un problème de valeur propre généralisé par manipulation algébrique au prix de la résolution d’un système plus grand.

Les propriétés d’orthogonalité des vecteurs propres permettent de découpler les équations différentielles afin que le système puisse être représenté comme une sommation linéaire des vecteurs propres. Le problème des valeurs propres des structures complexes est souvent résolu à l’aide d’ une analyse par éléments finis , mais généralisez soigneusement la solution aux problèmes de vibration à valeur scalaire.

Visages propres

Eigenfaces comme exemples de vecteurs propres

Eigenfaces comme exemples de vecteurs propres

En traitement d’images , les images traitées de visages peuvent être vues comme des vecteurs dont les composantes sont les luminosités de chaque pixel . [49] La dimension de cet espace vectoriel est le nombre de pixels. Les vecteurs propres de la matrice de covariance associée à un large ensemble d’images normalisées de visages sont appelés faces propres ; ceci est un exemple d’ analyse en composantes principales . Ils sont très utiles pour exprimer n’importe quelle image de visage comme une combinaison linéaire de certains d’entre eux. Dans la branche de la reconnaissance faciale de la biométrie , les faces propres fournissent un moyen d’appliquer la compression des données aux visages pour l’ identification . Des recherches liées aux systèmes de vision propres déterminant les gestes de la main ont également été menées.

Semblable à ce concept, les eigenvoices représentent la direction générale de la variabilité des prononciations humaines d’un énoncé particulier, tel qu’un mot dans une langue. Sur la base d’une combinaison linéaire de tels eigenvoices, une nouvelle prononciation vocale du mot peut être construite. Ces concepts se sont avérés utiles dans les systèmes de reconnaissance automatique de la parole pour l’adaptation au locuteur.

Tenseur du moment d’inertie